阿里通义发布Qwen3-Omni-Flash全模态大模型

快速阅读: 阿里通义Qwen团队发布消息称,其最新模型Qwen3-Omni-Flash-2025-12-01作为原生全模态大模型,支持文本、图像、音视频实时交互,并提升多语言处理、语音拟人化及系统提示自定义能力,显著优化人机对话自然度与精准度。

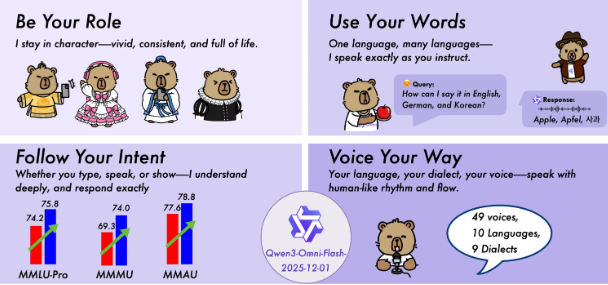

近日,阿里通义Qwen团队发布了最新版本Qwen3-Omni-Flash-2025-12-01。该模型基于Qwen3-Omni构建,作为新一代原生全模态大模型,可高效处理文本、图像、音频和视频等多种输入形式,并支持实时流式响应,同步生成文本与自然语音输出。

此次升级显著提升了音视频交互体验。新版本增强了对音视频指令的理解与执行能力,有效缓解了口语化场景中常见的响应失准问题。同时,多轮音视频对话的稳定性与连贯性也得到优化,使人机交互更为自然流畅。

此外,系统提示(System Prompt)控制能力实现重要突破。用户可全面自定义系统提示,精准调控模型行为,包括角色风格、口语表达偏好及回复长度等,显著提升交互的个性化水平。

在多语言处理方面,该版本支持119种文本语言、19种语音识别语言和10种语音合成语言。相较前代,其在跨语言场景下的响应准确性与一致性全面增强。

语音生成表现亦更加拟人化。新模型有效改善了语速拖沓与机械感问题,可根据文本内容自适应调整语速、停顿和韵律,使语音输出更贴近真实对话。

综合性能指标显示,Qwen3-Omni-Flash-2025-12-01在文本理解与生成、语音识别精准度、语音合成自然度以及图像理解深度等方面均显著优于此前版本,为用户提供更自然、精准、生动的AI交互体验。

(以上内容均由Ai生成)