苹果推STARFlow-V,30秒视频稳如初

快速阅读: 据苹果公司发布消息称,其推出全新视频生成模型STARFlow-V,采用归一化流技术提升长视频稳定性,支持多任务生成,虽在VBench测试中略逊顶尖模型,但运动一致性更优,代码已开源。

苹果公司近日发布全新视频生成模型STARFlow-V,该模型摒弃当前主流的扩散模型技术,首次采用“归一化流”方法,旨在提升长视频生成的稳定性与效率。与依赖多步迭代去噪的扩散模型不同,STARFlow-V直接学习随机噪声与视频数据间的数学变换,实现一次性训练和快速视频生成,显著减少错误累积。

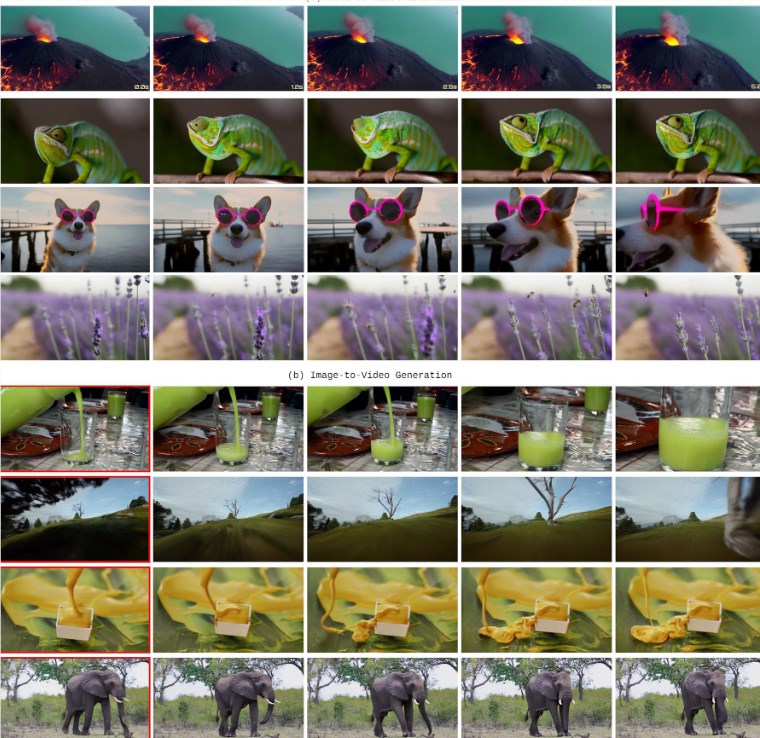

该模型采用双架构设计:一个组件负责跨帧时间序列以保障运动一致性,另一个优化单帧细节以提升画面质量。在演示中,STARFlow-V成功生成30秒稳定视频,而部分竞品在数秒后即出现模糊或色彩失真。此外,它支持文本转视频、图像转视频及视频编辑等多种任务,无需结构调整。

在VBench基准测试中,STARFlow-V得分79.7,虽略低于顶尖扩散模型Veo3(85.06)和HunyuanVideo(83.24),但在空间关系与人体表征方面明显优于其他自回归模型。不过,该模型目前分辨率仅为640×480、帧率为16帧/秒,尚无法在普通显卡上实时运行,且在物理模拟方面存在缺陷,如出现“章鱼穿过玻璃”等不合理场景。

苹果表示,未来将聚焦提升计算速度、压缩模型规模,并引入更注重物理准确性的训练数据。相关代码已开源至GitHub,模型权重将陆续在Hugging Face平台发布。

(以上内容均由Ai生成)