全球首发NavFoM:跨本体全域环视导航大模型

快速阅读: 银河通用联合多所高校推出全球首个跨本体全域环视导航基座大模型NavFoM,支持全场景零样本运行,具备多任务处理能力,引入TVI Tokens和BATS策略,数据集规模翻倍,提升机器人导航性能。

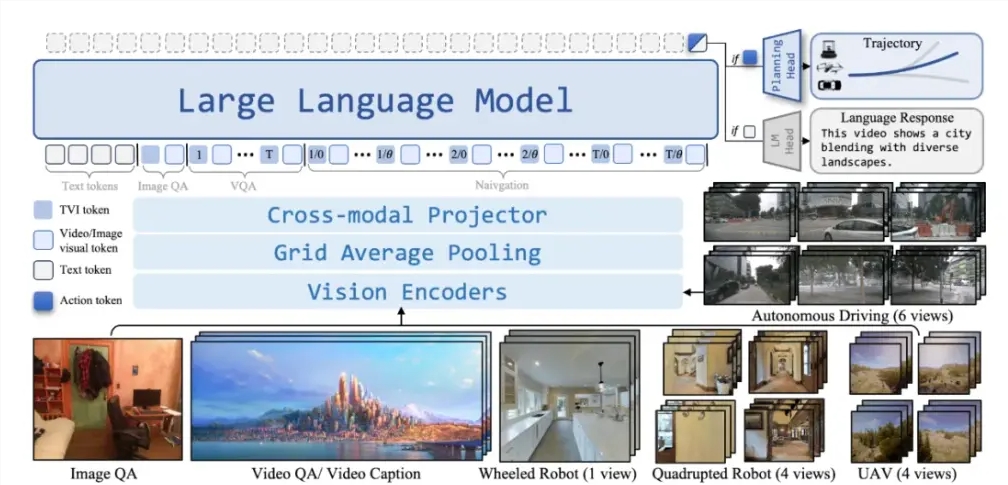

近日,银河通用联合北京大学、阿德莱德大学和浙江大学等团队,推出全球首个跨本体全域环视的导航基座大模型——NavFoM(Navigation Foundation Model)。该模型旨在将各类机器人导航任务整合至同一框架,涵盖视觉与语言导航、目标导向导航、视觉追踪及自主驾驶等多个应用场景。

NavFoM 的一大特点是全场景支持,无论是在室内还是室外,模型均可在未见过的环境中实现零样本运行,无需额外的建图或数据采集。这使得用户能够更便捷地将技术应用于各种环境,简化了前期准备流程。

此外,NavFoM 具备多任务支持功能,可通过自然语言指令完成目标跟随和自主导航等任务。这一设计让不同类型的机器人,如机器狗、无人机、轮式人形机器人和汽车等,都能在此框架下高效运作。

技术方面,NavFoM 引入了两项关键创新:一是 TVI Tokens(Temporal-Viewpoint-Indexed Tokens),赋予模型理解和处理时间与视角的能力;二是 BATS 策略(Budget-Aware Token Sampling),确保模型在计算资源有限时仍能保持高性能。

值得一提的是,NavFoM 构建了一个包含约八百万条跨任务、跨本体导航数据的大型数据集,以及四百万条开放问答数据。这些数据的规模是之前研究的两倍,增强了模型的语言和空间语义理解能力。

NavFoM 的发布标志着机器人导航领域的重要进展,开发者可基于此模型,通过进一步训练开发出满足特定需求的应用模型。

(以上内容均由Ai生成)