LLaVA-OneVision-1.5开源,多模态模型新突破

快速阅读: 开源社区推出LLaVA-OneVision-1.5,多模态模型支持图像、视频输入,训练分三阶段,提升视觉语言理解,性能优异超越Qwen2.5-VL。

近日,开源社区推出了LLaVA-OneVision-1.5,这是一款全新的多模态模型,标志着技术的重大突破。LLaVA(大型语言与视觉助手)系列经过两年的发展,已从最初的简单图文对齐模型,进化为能够处理图像、视频等多种输入形式的综合框架。

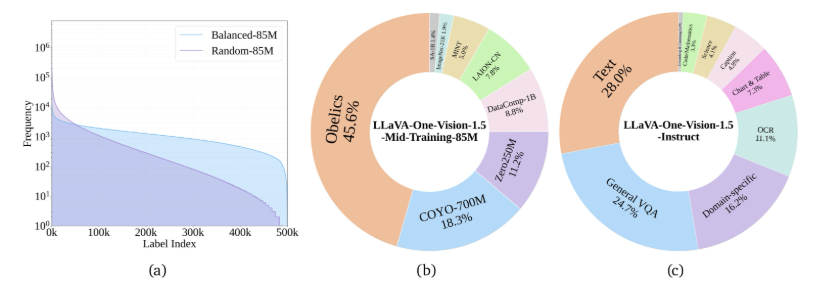

LLaVA-OneVision-1.5的核心目标是提供一个开放、高效且可复现的训练框架,便于用户构建高质量的视觉语言模型。其训练流程分为三个阶段:首先,通过语言-图像对齐的预训练阶段,模型学习如何将视觉特征转化为语言嵌入;其次,在“高质量知识学习”阶段,模型基于8500万个训练样本进行全面参数训练,注入大量视觉和知识信息,显著提升了模型性能;最后,在视觉指令微调阶段,利用精心设计的数据集进行训练,增强了模型处理各种复杂视觉指令的能力。

为了提高效率,开发团队采用了一种创新的离线并行数据打包方法,大幅提升了训练效率。在8500万个样本的基础上,数据处理的压缩比达到11倍,整个训练过程仅需3.7天即可完成。此外,LLaVA-OneVision-1.5还采用了RICE-ViT作为视觉编码器,具备区域感知的视觉理解能力,特别适用于处理文档中的文字信息。

数据是模型能力的基础,LLaVA-OneVision-1.5的预训练数据集不仅广泛多样,还引入了“概念均衡”的采样策略,确保模型在各类任务上的表现均衡。该模型在多项基准测试中表现出色,尤其是在80亿参数版本中,在27个基准测试中超越了Qwen2.5-VL的表现。

项目链接:https://github.com/EvolvingLMMs-Lab/LLaVA-OneVision-1.5 和 https://huggingface.co/lmms-lab/LLaVA-OneVision-1.5-8B-Instruct

重点:

– LLaVA-OneVision-1.5是最新的开源多模态模型,能够处理图像和视频等多种输入。

– 训练过程分为三个阶段,旨在高效提升模型的视觉与语言理解能力。

– 在基准测试中,LLaVA-OneVision-1.5的表现优异,超越了Qwen2.5-VL模型。

(以上内容均由Ai生成)