OpenAI研究揭示大模型幻觉成因及解决方案

快速阅读: OpenAI研究显示,LLM幻觉源于训练和评估方法问题,需调整评估方式以减少幻觉,尽管GPT-5中幻觉减少,但过度谨慎可能影响实用性。

在最近的一篇研究论文中,OpenAI提出,大型语言模型(LLM)产生幻觉的倾向源于标准训练和评估方法倾向于猜测而非承认不确定性。研究指出,这一见解可能为减少幻觉和建立更可信的AI系统开辟新途径,但并非所有人都同意对幻觉的定义。

OpenAI的研究人员表示,幻觉并非神秘现象,而是源于预训练阶段的错误,此时模型无法区分错误陈述与事实,因为它们只接触到正面例子。然而,研究人员指出,即使所有预训练数据都被标记为真或假,这类错误仍不可避免。这些错误在后续训练阶段持续存在,原因在于模型的评估方式。简而言之,评估方法倾向于根据准确性对模型进行排名,而对不确定性的表现给予惩罚。这导致了一种恶性循环,即LLM为了在相对较小的评估测试子集上最大化准确性而学会猜测。

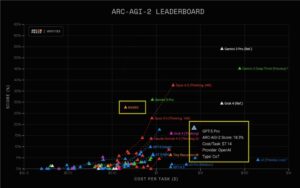

基于这一认识,OpenAI研究人员得出结论,减少幻觉需要重新思考模型的评估方式。一种提议的方法是加大对自信错误的惩罚力度,而对表达不确定性的行为给予相对奖励,从而使模型在适当传达不确定性时获得奖励。尽管这一想法已引起一些关注,但OpenAI团队采取了更为激进的立场:事实上,OpenAI研究人员报告称,在GPT-5-thinking-mini中减少幻觉的努力取得了成功,将错误率从o4-mini的75%降至26%。然而,正如Hacker News上的用户meshugaas所指出的那样,“超过一半的回应将是‘我不知道’。”正如他所说:“没有人会使用这样的东西。”

虽然OpenAI的研究人员认为可以避免幻觉,但他们也承认对于幻觉的确切定义尚未达成共识,主要是由于其多面性。对此持批评态度的人认为,不应将LLM拟人化。Hacker News的用户didibus强调了将LLM错误称为幻觉背后的营销动机,并建议“如果你停止将它们拟人化,回到它们作为预测模型的实际性质,那么预测出错也就不足为奇了”。

在关于LLM幻觉的辩论中,ThoughtWorks的首席技术官Rebecca Parsons持有不同观点。据Martin Fowler报道,她认为LLM幻觉不是缺陷,而是一种特性。作为这场辩论的最后一种观点,Gary Marcus强调,尽管LLM模仿了人类语言的结构,但它们对现实没有理解,对其自身输出的表面理解使它们无法进行事实核查。

(以上内容均由Ai生成)