大模型伦理安全综述发布,揭示新挑战与对策

快速阅读: 刘峰等开展《大规模语言模型的伦理安全:系统综述》研究,探讨LLMs信息安全威胁及防御策略,关注社会伦理影响,提出加强伦理治理方向。

随着自然语言处理技术的快速进步,以GPT、BERT和T5为代表的大规模语言模型(LLMs)已在教育、医疗、政治等领域广泛应用,显著提升了工作效率,降低了成本,并促进了数字化和智能化的发展。然而,LLMs的广泛使用也带来了新的安全挑战和伦理问题,引起了学术界和社会的广泛关注。

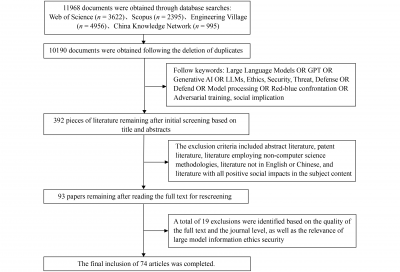

为此,刘峰、姜佳琪、陆雅婷、黄湛一和姜九铭共同开展了题为《大规模语言模型的伦理安全:系统综述》的研究。该研究从2020年到2024年1月,系统地回顾了LLMs在信息安全和社会伦理领域的学术进展。通过在Web of Science、Scopus、Ei Village和中国知网等数据库中使用特定关键词进行文献检索,并基于标题、摘要和全文质量筛选,最终选定了74篇相关研究文章进行深入分析。

研究深入探讨了LLMs面临的信息安全威胁,包括利用LLMs实施的不当行为(如网络钓鱼攻击、社会工程攻击、恶意软件威胁、黑客攻击和虚假信息生成)以及针对LLMs的恶意攻击(如数据和模型层面的攻击、使用和交互层面的攻击)。研究还总结评估了当前基于LLMs的防御策略,这些策略分为模型部署前的防御措施(包括参数处理、输入预处理和对抗训练)和部署后的应急措施,并讨论了LLMs生成内容的检测方法。此外,研究还考察了LLMs的社会伦理影响,重点关注输出幻觉、偏见、数据隐私泄露和对人类自主性的影响,并比较了中外学者在这一领域的研究差异。

最后,论文提出了未来加强LLMs安全应用和伦理治理的方向,包括开发智能自动化对抗训练方法、探索多模态和跨语言防御机制、建立伦理和法律框架,以及实现LLMs与人类价值观的对齐,旨在为LLMs技术的未来安全应用和发展提供理论基础和全面视角。

该论文《大规模语言模型的伦理安全:系统综述》发表于《前沿工程管理》2025年第12卷第1期,页码128-140,DOI: https://doi.org/10.1007/s42524-025-4082-6。本研究得到了北京大学北京行为与心理健康重点实验室的支持。

(以上内容均由Ai生成)