光芯片能耗比电子芯片低百倍,AI计算迎新突破

快速阅读: 佛罗里达大学领导团队开发出光子AI芯片,采用菲涅尔透镜架构执行卷积运算,功耗较电子芯片降低百倍,精度达98.1%,适用于边缘设备AI推理。

由佛罗里达大学领导的研究团队,与加州大学洛杉矶分校和乔治华盛顿大学合作,开发了一种原型光子人工智能芯片。该芯片通过光执行卷积运算,与电子等效物相比,功耗降低了两个数量级。创新之处在于一种完全集成的菲涅尔透镜架构,在芯片上执行二维空间卷积,全部在模拟光学域内完成。

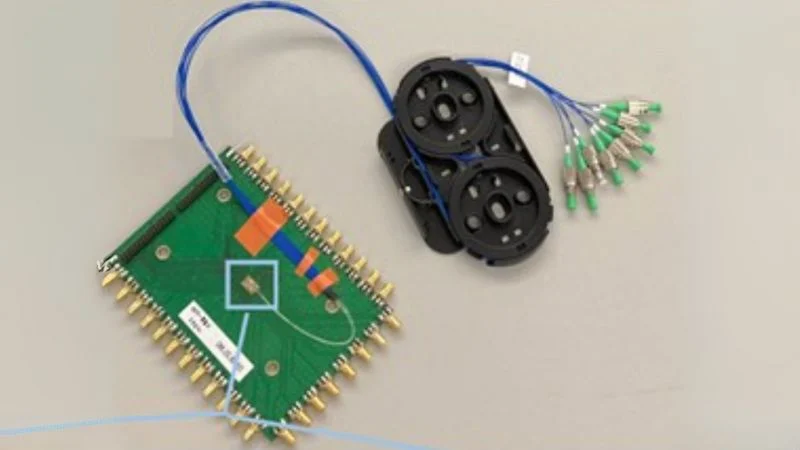

封装的光联合变换相关器包含硅光子芯片、定制PCB板和八通道光纤阵列。该芯片是同类产品中首个通过无源衍射光学实现空间卷积的,单片集成到硅光子基底上。原型芯片为深度学习中最耗能的操作之一——卷积神经网络(CNN)中的乘积累加(MAC)操作,解锁了接近零能耗的计算。

研究人员使用经过训练以分类MNIST数据集中手写数字的CNN测试了芯片。光子卷积模块作为网络的第一层,将学习到的内核应用于输入图像。网络的其余部分以数字方式实现,模拟混合推理流程。研究结果显示,芯片实现了98.1%的分类准确率,几乎与纯电子推理管道无法区分。但在能源效率方面,差异显著。与传统的数字卷积引擎(基于CPU、GPU或FPGA)相比,光子芯片将每次推理的能耗降低了100倍,预计消耗低至每操作皮焦耳。

值得注意的是,该架构对波长不敏感,并支持波分复用(WDM)。通过使用不同的波长作为不同的数据通道,可以在相同的物理结构中并行运行多个卷积操作,提高计算吞吐量而不增加占地面积或热负荷。

这种光学CNN加速器解决了边缘部署AI时最大的瓶颈之一——功率密度。随着CNN的深度和复杂度增加,卷积成为计算预算的主要部分。在紧凑的边缘设备如传感器、无人机、可穿戴设备或植入设备中运行AI推理,不仅需要效率,还需要热静默和最小化占用空间。

通过这种基于透镜的方法,计算是被动的、无风扇的且本质上并行的。它绕过了电子加速器面临的问题,如内存带宽、数据移动瓶颈和热节流。由于光的模拟性质允许连续值内核应用,因此避免了量化或剪枝的妥协。

此外,由于芯片采用标准光刻技术制造,可以与现有的硅光子平台单片集成或与CMOS后端配对。这比以前的自由空间光学或光纤耦合设计更为实用,后者需要笨重的设置,不适合商业集成。

这是一种新的混合计算模型。虽然芯片不是完整的神经处理器,只处理卷积步骤,但通过将最耗能的前端计算卸载到光学,而将决策逻辑或全连接层留给传统硅,定义了一种新的混合计算模型。未来的系统可能在同一基底上共集光子加速器用于CNN、数字控制器用于逻辑和存储器阵列用于数据存储。

随着AI硬件竞赛的加速,像这样的创新指向了一个未来,其中计算不再局限于电子和晶体管,而是扩展到光子、干涉和光的基本属性。该原型是在美国海军研究办公室的资金支持下开发的,并在《高级光子学》杂志上发表,作为硅兼容、被动、芯片上卷积的同行评审演示。

所有图片均来自《高级光子学》。

(以上内容均由Ai生成)