硅基流动上线Ling-flash-2.0,推理速度大幅提升

快速阅读: 硅基流动平台上线蚂蚁集团百灵团队开源的Ling-flash-2.0,拥有100亿参数,支持128K上下文长度,性能优于40亿参数Dense模型,新用户可获赠金体验。

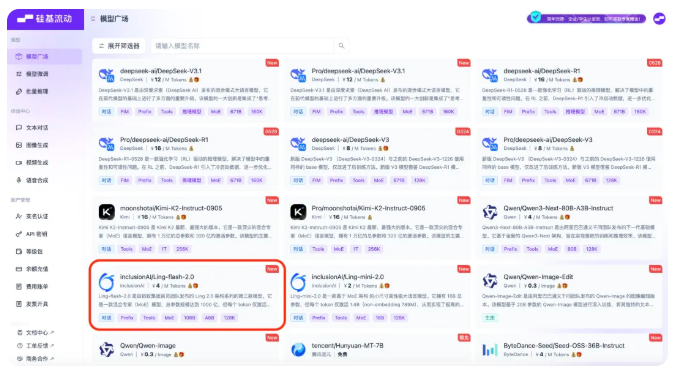

近日,硅基流动大模型服务平台正式上线了蚂蚁集团百灵团队最新开源的Ling-flash-2.0,这是该平台上线的第130个模型。Ling-flash-2.0是一款基于MoE架构的大型语言模型,拥有100亿参数,激活时仅使用6.1亿参数(非嵌入激活4.8亿)。经过20TB以上高质量语料的预训练、监督微调和多阶段强化学习,该模型在激活6亿以上参数的情况下,展现出与40亿参数Dense模型相当的卓越性能。

Ling-flash-2.0在复杂推理、代码生成和前端研发等领域表现优异,支持最大128K的上下文长度,为用户提供强大的文本处理能力。其定价亲民,输入每百万个Token收费1元,输出每百万个Token收费4元。新用户在国内和国际站分别可获得14元或1美元的使用体验赠金。

Ling-flash-2.0在性能方面具有显著优势。与40亿参数以下的Dense模型(如Qwen3-32B-Non-Thinking和Seed-OSS-36B-Instruct)及更大激活参数的MoE模型(如Hunyuan-A13B-Instruct和GPT-OSS-120B/low)相比,Ling-flash-2.0展现了更强的复杂推理能力,尤其在创作类任务中表现出色。

此外,Ling-flash-2.0的架构设计精良,能够实现极速推理。在Ling Scaling Laws的指导下,Ling2.0采用了1/32激活比例的MoE架构,并在多个细节上进行了优化,使小激活的MoE模型获得了与Dense架构相当的性能优势。通过H20进行部署时,Ling-flash-2.0的输出速度可达每秒200多个Token,比36B的Dense模型提高了3倍以上的速度。

硅基流动平台致力于为开发者提供快速、经济、可靠的大模型API服务。除了Ling-flash-2.0,平台上还汇集了多种语言、图像、音频、视频等模型,满足开发者的不同需求。开发者可在平台上自由对比和组合各类模型,轻松调用高效的API,助力生成式AI应用的最佳实践。

国内站在线体验:https://cloud.siliconflow.cn/models

国际站在线体验:https://cloud.siliconflow.com/models

重点提示:

🌟 Ling-flash-2.0是基于MoE架构的100亿参数语言模型,具备强大的复杂推理能力。

⚡ 模型支持最大128K的上下文长度,提供极速推理体验,输出速度可达每秒200+Token。

💰 新用户可在国内和国际站获得使用体验赠金,硅基流动平台提供多种大模型服务,助力开发者创新。

(以上内容均由Ai生成)