谷歌发布差分隐私语言模型VaultGemma,保护用户数据安全

快速阅读: 谷歌DeepMind推出开源语言模型VaultGemma,具备10亿参数和差分隐私技术,防止训练时泄露敏感信息,增强用户数据隐私保护,性能保守但安全性强,将在Hugging Face和Kaggle上公开。

谷歌 DeepMind 最近推出了名为 VaultGemma 的新语言模型,该技术致力于保护用户隐私。VaultGemma 不仅开源,而且是目前最大规模的具备差分隐私能力的语言模型,参数量达10亿。这一技术的发布标志着人工智能领域在用户数据隐私保护上的重要进展。

传统大型语言模型在训练时可能无意中记住了某些敏感信息,例如姓名、地址和机密文档等。为解决这一问题,VaultGemma 引入了差分隐私技术,在训练过程中加入可控的随机噪声,确保模型输出不会与特定的训练样本关联。这意味着即便 VaultGemma 曾接触过机密文件,从统计学角度也难以还原其内容。谷歌的初步测试表明,VaultGemma 确实未泄露或复现任何训练数据,增强了用户的信任度。

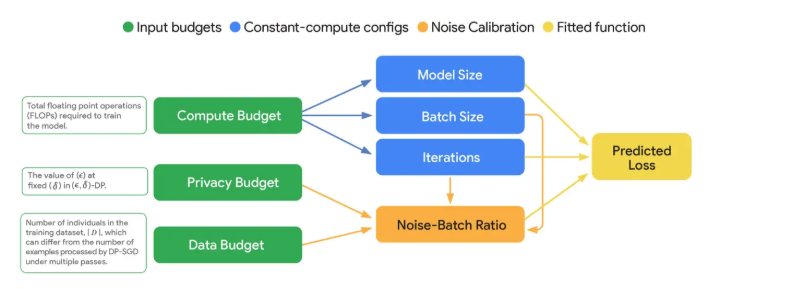

在技术架构上,VaultGemma 基于 Google 的 Gemma2 架构,采用仅解码器的 Transformer 设计,共26层,并运用了多查询注意力机制。一个重要的设计决策是将序列长度限定为1024个 Token,这有助于管理私有训练所需的高密度计算。开发团队还利用了一种新的“差分隐私缩放定律”,为计算能力、隐私预算和模型效用之间的平衡提供了框架。

虽然 VaultGemma 的性能与五年前的普通语言模型相当,生成能力较为保守,但在隐私保护方面提供了更强的保障。谷歌的研究人员表示,他们将以开源许可证在 Hugging Face 和 Kaggle 上公开 VaultGemma 及其相关代码库,使更多人能够便捷地获取这一私有 AI 技术。

这款模型的推出无疑为隐私安全与开源技术的融合开辟了新的路径,期待它未来能为用户提供更安全可靠的体验。

(以上内容均由Ai生成)