硅基流动上线Ling-mini-2.0,性能速度双突破

快速阅读: 硅基流动平台推出蚂蚁集团百灵团队开源的Ling-mini-2.0模型,采用MoE架构,总参数16B,生成速度快,支持128K上下文,性能优越,促进AI应用。

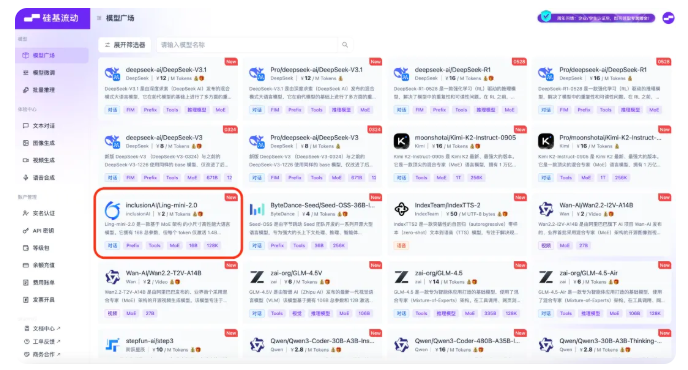

近日,硅基流动大模型服务平台正式上线了蚂蚁集团百灵团队最新开源的Ling-mini-2.0。这款新模型不仅保持了先进的性能,还展现了极高的生成速度,标志着在小体量模型中实现了大能量的突破。

Ling-mini-2.0采用了MoE架构,总参数量达到16B,但在生成过程中每个Token仅激活1.4B的参数,这显著提高了生成速度。这种设计不仅确保了模型在处理任务时仍能保持卓越性能,还能够与10B以下的Dense语言模型及其他更大规模的MoE模型进行有效的比较。其最大上下文长度可达128K,极大地拓展了模型的应用范围。

在基准测试中,Ling-mini-2.0在多个领域的推理任务中表现出色。无论是在编码、数学还是知识密集型推理任务中,Ling-mini-2.0均取得了令人满意的成绩,展示了其强大的综合推理能力。尤其是在高难度任务中,该模型的性能优于众多同类产品。

此外,Ling-mini-2.0在生成速度方面也具有明显优势。在2000Token以内的问答任务中,其生成速度超过每秒300个Token,比传统8B的Dense模型快两倍以上。随着输出长度的增加,该模型的速度还能进一步提升,最高可达七倍的相对加速。

为了方便开发者使用,硅基流动平台提供了多种接入方案和API文档,支持开发者在平台上进行模型的对比与组合,帮助他们轻松实现生成式AI应用。平台内还有多款大模型API供开发者免费使用,进一步促进了AI技术的普及和应用。

要点:

– Ling-mini-2.0总参数16B,每个Token仅激活1.4B参数,实现高效生成。

– 模型支持128K的最大上下文长度,展现出强大的推理能力。

– 硅基流动平台提供多种接入方案,支持开发者轻松使用多款大模型API。

(以上内容均由Ai生成)