Liquid AI 发布轻量级多模态模型,加速AI视觉语言能力设备端部署

快速阅读: Liquid AI 发布 LFM2-VL 系列模型,加速多模态 AI 设备端部署。该系列轻量化设计,支持高效图像与文本处理,显著提升 GPU 推理速度,适用于手机等设备,减少云依赖,增强隐私保护。

Liquid AI 最新发布了 LFM2-VL 系列视觉语言基础模型(Vision-Language Foundation Models),这标志着多模态 AI 正在向“精简、快速、可部署在设备端”的方向加速发展。该系列包括 LFM2-VL-450M 和 LFM2-VL-1.6B 两个型号,前者专为资源受限的硬件环境设计,参数量不到5亿;后者虽然参数更多,但仍保持轻量化,适合在单个 GPU 或设备上直接部署。

LFM2-VL 基于 Liquid AI 早先推出的 LFM2 架构扩展而来,集成了视觉与语言处理能力,支持多分辨率图片输入,能够处理文本与图像,展现出极高的灵活性与兼容性。该模型在 GPU 推理速度上实现了高达两倍的提升,并在常见的性能测试中表现出色。

在图像处理方面,LFM2-VL 可接受最高512×512分辨率的原始图像输入,避免了因强制缩放导致的失真问题。对于更大的图像,模型通过非重叠切片的方式处理,并结合缩略图来获取全局上下文信息。其架构由语言模型主体、SigLIP2NaFlex 视觉编码器以及一个多模态投影器组成。投影器利用两层 MLP(带像素解混技术)减少图像 token 数量,提高处理速度。

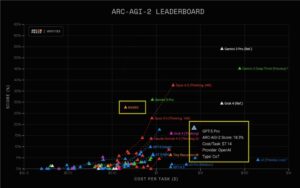

在训练数据方面,LFM2-VL 涉及约1,000亿个多模态训练 token,数据源包括开源数据集和公司自有的合成图像数据。评估结果显示,LFM2-VL-1.6B 在 RealWorldQA(65.23)、InfoVQA(58.68)、OCRBench(742)等任务中取得了优异的成绩,并且在推理效率上优于同类模型。

目前,这些模型已在 Hugging Face 平台上发布,并附有在 Colab 上的微调示例代码,兼容 Hugging Face Transformers 与 TRL 库。它们采用了基于 Apache2.0 原则的新“LFM1.0 许可协议”,允许学术使用,年收入低于1,000万美元的公司可用于商业目的,而年收入更高的企业则需联系 Liquid AI 获取授权。

Liquid AI 的 LFM2-VL 模型为视觉与文本融合的 AI 在设备端的部署开辟了新的途径,特别适用于手机、笔记本电脑、可穿戴设备等场景,有助于减少对云服务的依赖,提升隐私保护和响应速度。

(以上内容均由Ai生成)