新算法助力AI模型进化,无需昂贵再训练

快速阅读: 日本AI实验室Sakana AI开发新技术M2N2,无需昂贵训练即可增强AI模型,适用于多种机器学习模型,为企业提供高效定制解决方案,促进模型融合趋势。

日本人工智能实验室Sakana AI开发了一种新的进化技术,使开发者能够增强人工智能模型的能力,而无需昂贵的训练和微调过程。这项名为“自然生态位模型合并”(M2N2)的技术克服了其他模型合并方法的局限性,甚至可以从头开始演化出全新的模型。

M2N2适用于各种类型的机器学习模型,包括大型语言模型(LLMs)和文本到图像生成器。对于希望构建定制AI解决方案的企业来说,这种方法提供了一种强大且高效的方式来创建专门模型,通过结合现有开源变体的优势实现目标。

维萨公司35亿美元押注AI

什么是模型合并?

模型合并在将多个专门的AI模型的知识整合到一个更强大的单一模型中。与通过新数据精调单个预训练模型不同,合并同时结合多个模型的参数。这一过程可以在不需要昂贵的基于梯度的训练或访问原始训练数据的情况下,将大量知识整合到一个资产中。

对于企业团队而言,这比传统的精调方法提供了几个实际优势。论文作者在接受VentureBeat采访时指出,模型合并是一个无梯度的过程,只需要前向传递,因此计算成本低于需要昂贵梯度更新的精调。合并还避免了需要仔细平衡的训练数据,并减少了“灾难性遗忘”的风险,即模型在学习新任务后失去原有能力。当无法获得专门模型的训练数据时,这种技术尤为强大,因为合并仅需模型权重本身。

早期的模型合并方法需要大量的手动努力,开发人员通过试错调整系数以找到最佳组合。最近,进化算法帮助自动化了这一过程,通过搜索最优参数组合来实现。然而,一个重要的人工步骤仍然存在:开发人员必须设置可合并参数的固定集,如层。这种限制缩小了搜索空间,可能阻碍更强大组合的发现。

M2N2如何工作

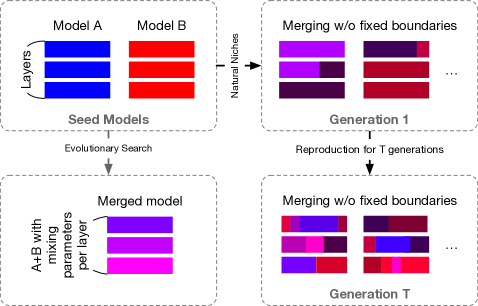

M2N2通过借鉴自然界的进化原则解决了这些限制。该算法具有三个关键特性,使其能够探索更广泛的可能并发现更有效的模型组合。

首先,M2N2消除了固定的合并边界,如块或层。它不按预定义的层分组参数,而是使用灵活的“分割点”和“混合比率”来划分和组合模型。例如,算法可能会将模型A某一层次的30%参数与模型B同一层次的70%参数合并。该过程从一组种子模型的“档案”开始。每一步,M2N2从档案中选择两个模型,确定混合比率和分割点,然后合并它们。如果生成的模型表现良好,就会被添加回档案,替换较弱的模型。研究人员指出:“这种逐步引入复杂性的方法确保了更广泛的可能性,同时保持计算可行性。”

其次,M2N2通过竞争管理其模型种群的多样性。为了理解多样性的重要性,研究人员提供了一个简单的类比:“想象合并两张考试答案……如果两张答案完全相同,合并不会带来任何改进。但如果每张答案对不同的问题都正确,合并后会得到更强的结果。”模型合并也是如此。挑战在于定义有价值的多样性类型。M2N2不依赖手工制作的指标,而是模拟有限资源的竞争。这种自然启发的方法自然奖励具有独特技能的模型,因为它们可以“利用未竞争的资源”解决其他人无法解决的问题。作者指出,这些特定领域的专家是合并中最宝贵的。

M2N2采用一种称为“吸引力”的启发式方法来配对模型进行合并。与简单组合表现最佳模型的其他合并算法不同,M2N2根据模型的互补优势进行配对。“吸引力得分”用于识别一个模型在另一模型难以处理的数据点上表现良好的配对。这不仅提高了搜索效率,还提升了最终合并模型的质量。

研究人员在三个不同领域测试了M2N2,展示了其多样性和有效性。

首先,研究团队在一个小规模实验中,从头开始进化基于神经网络的图像分类器,使用MNIST数据集。M2N2在测试准确率上大幅领先其他方法。结果显示,其多样性保护机制是关键,能够维持一个包含互补优势模型的档案库,从而实现有效合并,并系统地淘汰较弱的解决方案。

接下来,他们将M2N2应用于大语言模型,结合了一个数学专家模型(WizardMath-7B)和一个代理专家模型(AgentEvol-7B),这两个模型都基于Llama 2架构。目标是创建一个在数学问题(GSM8K数据集)和基于网络的任务(WebShop数据集)上均表现出色的单一代理。合并后的模型在这两个基准测试中均取得了优异成绩,展示了M2N2创造强大多功能模型的能力。

最后,研究团队合并了基于扩散的图像生成模型。他们将一个接受日语提示训练的模型(JSDXL)与三个主要接受英语提示训练的稳定扩散模型相结合。目标是创建一个既能结合每个种子模型的最佳图像生成能力,又保留理解日语能力的模型。合并后的模型不仅生成了更加逼真的图像,具有更好的语义理解能力,还发展出了双语能力。它可以生成高质量的图像,无论提示是英语还是日语,尽管它仅使用日语标题进行了优化。

对于已经开发了专门模型的企业来说,合并的商业理由非常充分。作者指出,新的混合能力很难通过其他方式实现。例如,将一个经过微调的大型语言模型与一个能够解读客户反应的视觉模型合并,可以创建一个能够在实时视频反馈下调整销售策略的单一代理。这不仅解锁了多个模型的综合智能,还降低了运行成本和延迟。

展望未来,研究人员认为像M2N2这样的技术是向“模型融合”趋势的一部分。他们设想未来组织将维护整个不断进化的AI模型生态系统,以适应新的挑战。

“想象一个能力按需组合的生态系统,而不是从零开始构建一个巨大的单体模型。”作者建议道。

研究团队已在GitHub上发布了M2N2的代码。

研究人员认为,构建这种动态自改进AI生态系统的最大障碍不是技术上的,而是组织上的。“在一个由开源、商业和定制组件组成的大型‘合并模型’世界中,确保隐私、安全和合规性将是关键问题。”对企业而言,挑战在于确定哪些模型可以安全有效地整合到其不断进化的AI栈中。

(以上内容均由Ai生成)