Nous Research推出四款超ChatGPT的无限制AI模型

快速阅读: Nous Research发布Hermes 4大型语言模型,性能与专有系统相当,强调用户控制和透明度,挑战AI安全与内容审核标准,引发关于创新与监管的讨论。

Nous Research,一家低调的人工智能初创公司,在开源人工智能运动中崭露头角,周一悄然发布了大型语言模型系列Hermes 4。该公司声称,这些模型在性能上可与领先的专有系统相媲美,同时提供前所未有的用户控制权和最少的内容限制。

此次发布标志着开源AI倡导者与主要科技公司在谁应掌控先进人工智能能力的斗争中进一步升级。与OpenAI、Google或Anthropic的模型不同,Hermes 4设计为几乎可以响应任何请求,而无需商业AI系统中常见的安全防护措施。

“Hermes 4延续了我们以用户为中心的模型传统,并扩展了测试时计算能力,”Nous Research在X(原Twitter)上宣布,“特别注重使模型具有创意性和互动性,不受审查限制,保持中立对齐,同时维持开放权重模型在数学、编码和推理方面的最先进水平。”

Hermes 4引入了Nous Research所谓的“混合推理”模式,允许用户在快速响应和深入逐步思考之间切换。激活后,模型会在提供最终答案之前生成内部推理过程,类似于OpenAI的o1推理模型,但完全透明地展示AI的思考过程。

技术成就显著。在测试中,Hermes 4的最大4050亿参数模型在推理模式下在MATH-500基准测试中得分96.3%,在具有挑战性的AIME’24数学竞赛中得分81.9%——性能与许多成本高昂的专有系统相当甚至超越。

AI研究员Rohan Paul在X上指出:“挑战在于如何在不导致无节制推理的情况下,使思考轨迹有用且可验证。” 这一发布中的技术突破之一即在此。

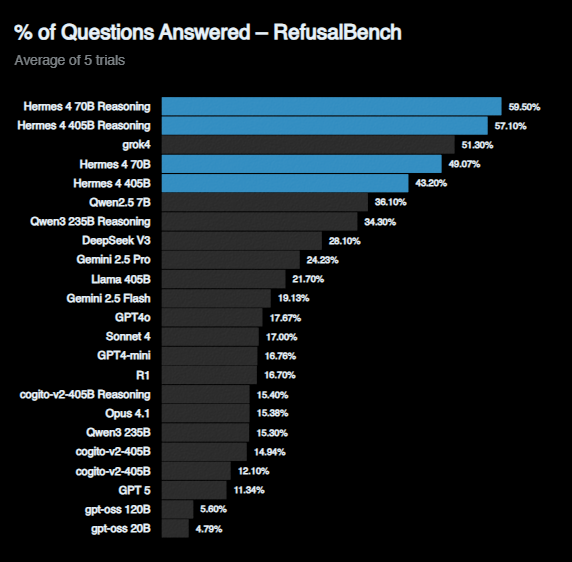

值得注意的是,Hermes 4在“拒绝基准”测试中取得了所有测试模型中的最高分。该基准由Nous Research创建,用于衡量AI系统拒绝回答问题的频率。在推理模式下,该模型得分为57.1%,远超GPT-4o(17.67%)和Claude Sonnet 4(17%)。

Hermes 4模型在拒绝基准测试中回答的问题明显多于竞争对手的AI系统。(图片来源:Nous Research)

支撑Hermes 4能力的背后是Nous Research多年来开发的复杂训练基础设施。这些模型使用两种新颖的系统进行训练:DataForge,一种基于图的合成数据生成器;Atropos,一个开源强化学习框架。

DataForge通过在有向图中进行“随机游走”来生成训练数据,将简单的预训练数据转化为复杂的指令跟随示例。例如,它可以将维基百科文章转化为说唱歌曲,然后生成基于该转化的问题和答案。

Atropos则像数百个专门的训练环境,AI模型在其中练习特定技能——数学、编码、工具使用和创造性写作,只有在产生正确解决方案时才会收到反馈。“拒绝采样”方法确保只有经过验证的高质量响应进入训练数据。

“Nous利用这些环境生成了Hermes 4的数据集!”Delphi Ventures的风险投资家Tommy Shaughnessy解释道,“数据集中包含350万个推理样本和160万个非推理样本!Hermes是在RL数据上训练的,而不仅仅是静态的问题和答案数据集!”

训练过程需要192个Nvidia B200 GPU和71,616个GPU小时,对于最大模型而言,这是一笔巨大的但并非前所未有的计算投资,展示了专门技术如何与科技巨头的大规模竞争。

Nous Research认为,AI安全防护措施“烦人透顶”,阻碍了创新。

Nous Research 坚持以用户控制为核心理念,建立了良好的声誉。该公司设计的模型具有“可操控性”,即可以根据特定需求进行微调或引导,而不需要像商业AI系统那样受到严格的约束。

“Hermes 4 不受免责声明、规则和过度谨慎的束缚,这非常烦人且损害创新和可用性,”Shaughnessy 在详细分析Hermes 4 发布的帖子中写道,“如果开源但拒绝所有请求,那就毫无意义。Hermes 4 没有这样的问题。”

这种做法使 Nous Research 在希望获得最大灵活性的AI研究人员和开发者中广受欢迎,但也使公司在关于AI安全和内容审核的持续争论中处于中心位置。虽然这些模型理论上可以用于有害目的,但 Nous Research 认为透明度和用户控制优于企业审查。

该公司发布的技术报告提供了前所未有的训练过程、评估结果和基准测试的实际文本输出细节。“我们相信这份报告为基准测试设定了新的透明度标准,”公司表示。

这家拥有192个GPU的小型初创公司如何与大科技公司的数十亿美元AI预算竞争?Hermes 4 的发布正值AI行业的重要时刻。尽管大型科技公司投入巨资开发越来越强大的AI系统,但开源运动认为这些能力不应由少数几家公司控制。

近几个月来,开源AI取得了显著进展,Meta 的 Llama 3.1、DeepSeek 的 R1 和阿里巴巴的 Qwen 系列等模型的性能已经接近专有系统。Hermes 4 在推理领域迈出了一步,这一领域长期被认为是封闭系统的强项。

“首先,Nous 是一家拥有几十名极其优秀人才的初创公司,”Shaughnessy 指出,“他们没有超大规模企业的每年超过100亿美元的资本支出,也没有数千名员工,但他们仍然以惊人的速度不断创新和研究。”

今年早些时候,该公司在 Paradigm 领投的一轮融资中筹集了6500万美元,还在开发 Psyche Network,这是一个旨在利用区块链技术协调互联网连接计算机上的AI训练的分布式系统。

Hermes 4 解决了推理模型中常见的问题:过长的思考过程。研究人员发现,他们的140亿参数模型在推理时有60%的时间达到最大上下文长度,几乎陷入无休止的循环。

他们的解决方案是第二阶段的训练,教会模型在恰好3万个标记处停止推理,将过长生成减少65-79%,同时保持大部分推理性能。这种“长度控制”技术可能对整个AI研究社区都有价值。

“较小的模型(<14B)在蒸馏时容易过度思考,但较大的模型则不会,”AI研究员 Muyu He 在X上指出,提到了技术报告中的见解。

然而,Hermes 4 仍面临开源模型的常见限制。尽管在基准测试中表现出色,但运行这些模型需要大量的计算资源,对于许多应用来说,可能无法与商业AI服务的易用性和可靠性相匹敌。

Nous Research 通过多个渠道提供了 Hermes 4,体现了开源理念。模型权重可在 Hugging Face 上免费下载,公司还通过其改进的聊天界面和与 Chutes、Nebius 和 Luminal 等推理提供商的合作提供API访问。

“您可以在新的 Nous Chat 界面中试用 Hermes 4,”公司宣布,强调了并行交互和记忆系统等功能。

对于企业和研究人员而言,这些模型可能是支付专有系统API访问费用的有吸引力的替代方案,特别是在需要高度定制或处理敏感内容的应用中。

Hermes 4 的发布不仅是一个新的AI模型的推出,更是关于谁应掌控人工智能未来的声明。在资源几乎无限的大科技公司主导的行业中,Nous Research 展示了创新仍可来自意想不到的地方。

公司采取的策略引发了关于安全与能力、企业控制与用户自由之间权衡的基本问题。虽然主要科技公司认为,谨慎的内容审核和安全措施是负责任地部署人工智能的关键,Nous Research则认为透明度和用户自主权比企业强加的限制更为重要。

这种理念最终是否会带来益处或问题,还有待观察。但有一点可以确定:Hermes 4 表明,未来的人工智能不会仅仅由财力雄厚的公司决定。

在昨天的不可能成为明天的寻常品的领域,Nous Research 刚刚证明,比起说“不”的人工智能,愿意说“是”的人工智能可能更加危险。

(以上内容均由Ai生成)