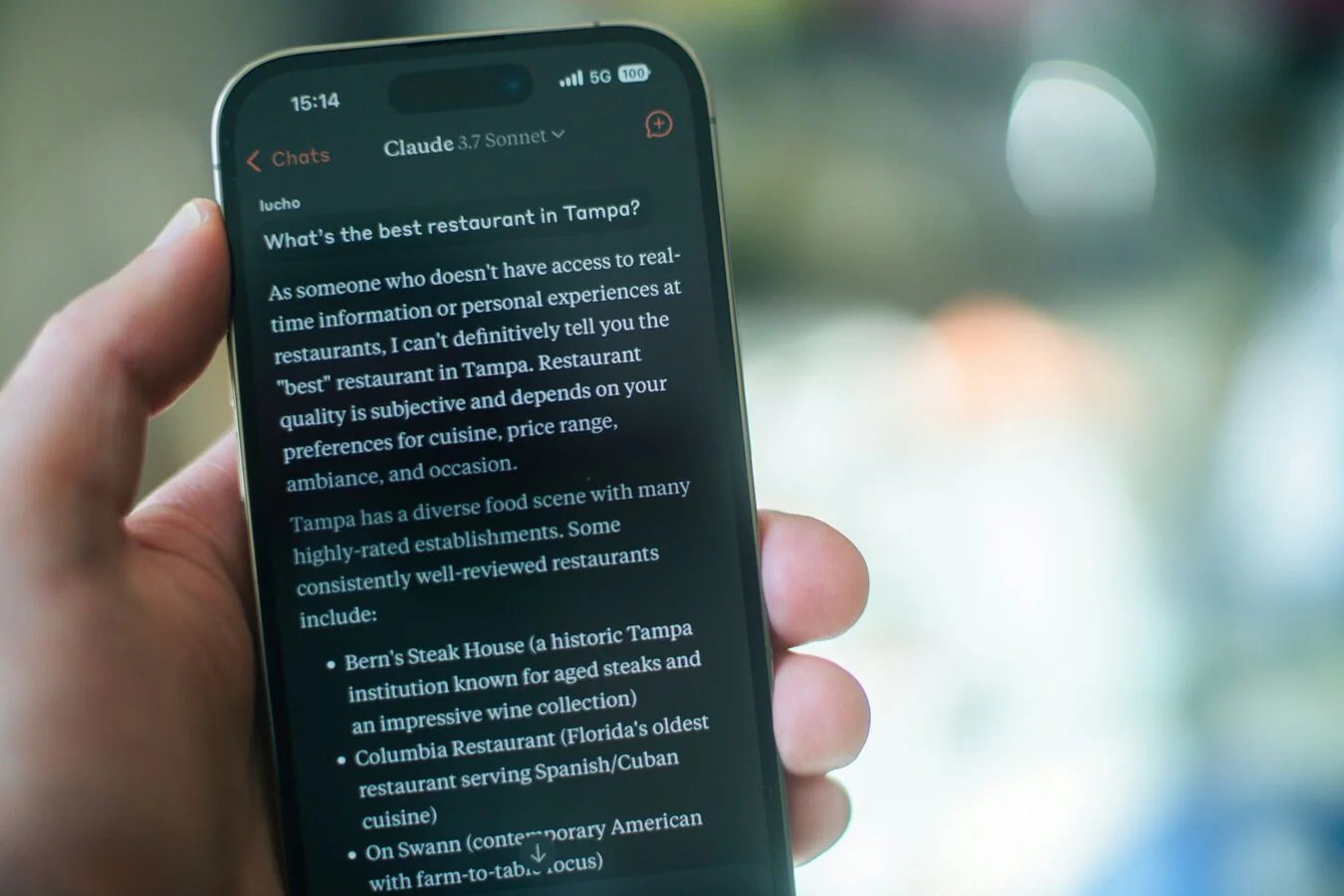

Claude AI默认训练个人对话,用户需手动关闭此设置

快速阅读: Anthropic宣布自9月28日起将使用用户数据训练AI模型,除非用户选择退出,消息保留期延长至五年,旨在提升模型安全性和用户体验。

Anthropic 对其用户数据处理方式进行了重大调整。该公司宣布,自9月28日起,除非用户选择退出,否则将开始使用用户数据训练其AI模型。此外,对于未选择退出AI训练的用户,发送给Claude的消息保留期限将延长至五年。

过去,Anthropic 从未使用用户消息训练AI模型,并声称会在30天内删除所有用户输入和输出,除非法律要求保留。然而,为了应对政策违规情况,公司仍会保存用户输入和输出长达两年。

此次更新将影响所有消费级用户,包括 Claude Free、Pro 和 Max 订阅者,以及通过关联账户使用 Claude Code 的用户。不过,商业计划如 Claude for Work、Claude Gov、Claude for Education 或 API 不受影响,即使通过第三方服务如亚马逊 Bedrock 和谷歌云 Vertex AI 使用也是如此。

Anthropic 表示,参与模型训练将有助于提高模型安全性,使系统更准确地检测有害内容,减少误报无害对话的情况。此外,这还将帮助未来的 Claude 模型提升编程、分析和推理能力,最终为所有用户带来更好的体验。

现有用户需在9月28日前决定是否参与数据训练。届时,Anthropic 将向用户显示一个弹窗,标题为“消费者条款和政策更新”。默认情况下,“现在可以改进 Claude”选项将被选中,用户可能无意中点击接受,从而同意数据训练。用户也可以选择“稍后”推迟决定,直到9月28日必须做出选择才能继续使用 Claude。

如果用户接受新条款,其数据将立即用于训练AI模型,但仅限于新的或恢复的聊天和编码会话,不会涉及过去的对话。但如果用户重新访问并输入消息,整个聊天记录可能会被用于训练AI。

新用户在注册过程中将被要求选择是否参与数据训练。

如何关闭 Claude 的数据训练?

如果您未注意到这些新变化,默认情况下您的对话可能已被用于训练 Anthropic 的AI模型。以下是取消数据训练的方法:

– 在网站上:

1. 点击左下角的个人资料,进入设置

2. 点击隐私,找到“帮助改进 Claude”的开关

3. 关闭该开关

– 在应用程序中:

1. 点击左上角的三条横线

2. 点击设置

3. 点击隐私,确保“帮助改进 Claude”的开关已关闭

(以上内容均由Ai生成)