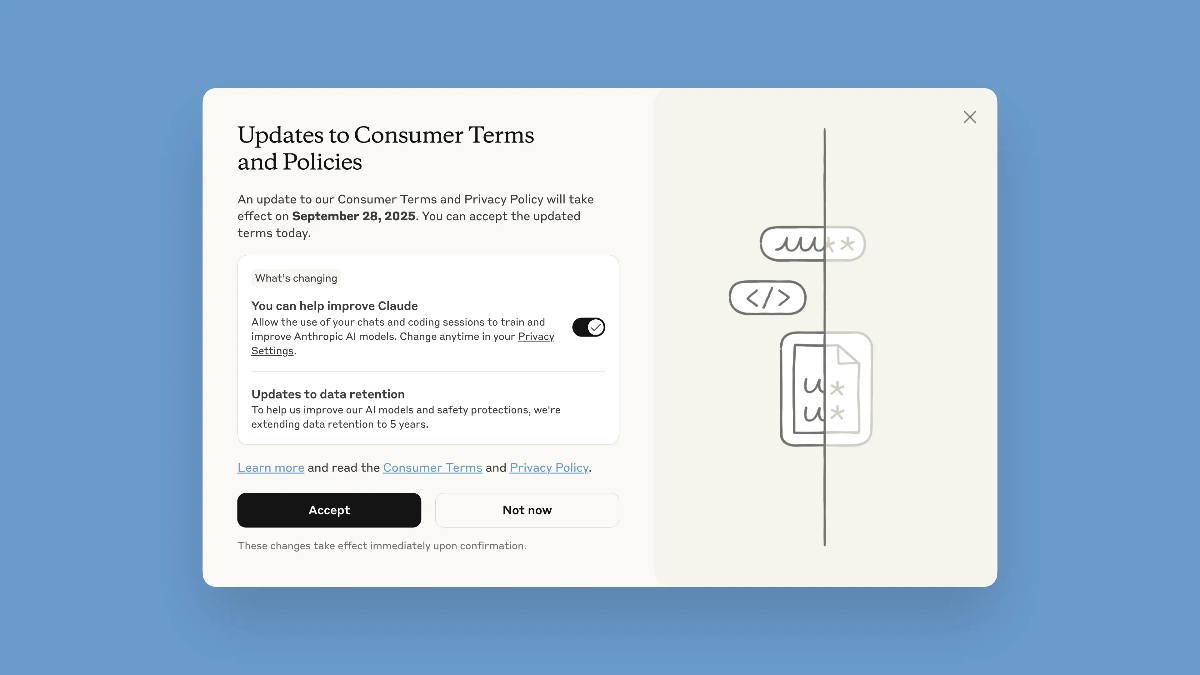

Anthropic将用用户数据训练AI模型,除非用户选择退出

快速阅读: Anthropic更新用户条款和隐私政策,允许使用聊天数据训练AI模型,用户可选择退出。新政策自2025年9月28日起生效,数据保留期限延长至5年,旨在提高安全性和防欺诈能力。

Anthropic宣布更新其用户条款和隐私政策。用户可以选择接受新政策,允许公司将聊天数据用于训练AI模型,也可以选择退出。此前,Claude AI并未使用用户数据来训练其语言模型。现在,用户与AI的对话将用于改进Claude,公司表示这有助于增强防止诈骗、滥用和其他有害内容的安全措施。此更改不影响现有聊天记录,但适用于新聊天和代码会话。

用户需在2025年9月28日前接受新条款,接受后立即生效。用户可以在隐私设置页面选择退出AI训练,网址为

新用户注册时将被要求选择是否同意数据使用。此外,Anthropic还将延长数据保留期限至5年,以帮助改善AI模型和安全保护。新条款规定,如果用户不同意提供数据用于模型训练,则不会存储数据。公司表示不会将用户数据出售给第三方。据《The Verge》报道,Claude AI将使用工具和自动化流程过滤或模糊敏感数据。

这些隐私政策变更不仅适用于Claude免费计划,还适用于Pro和Max计划。但这些规则不适用于“Anthropic商业条款”下的服务,如Claude for Work、Claude Gov、Claude for Education或API使用,包括通过Amazon Bedrock和Google Cloud的Vertex AI等第三方服务。

默认选择退出隐私变更的做法并不理想。为何设置一个选择退出的截止日期也让人费解。Vivaldi浏览器表示不会在其产品中添加AI功能,而一家知名AI服务则在隐私问题上改变了立场。

您如何看待Anthropic的这一举措?

(以上内容均由Ai生成)