阿里国际发布多模态大模型 Ovis2.5,推动视觉感知与深度推理新进展

快速阅读: 阿里国际发布Ovis2.5多模态大模型,开源并在OpenCompass评测中得分78.3,提供9B和2B两个版本,创新架构和训练策略,数据量增加50%,提升视觉推理能力。

近日,阿里国际发布了新一代多模态大模型 Ovis2.5,并对外开源。这款模型专注于原生分辨率视觉感知、深度推理以及高性价比的场景设计,旨在进一步提升人工智能的应用能力。Ovis2.5 在主流多模态评测套件 OpenCompass 上的综合得分相比前一版本 Ovis2 有了显著提升,继续在同类开源模型中保持 SOTA 水平。

此次发布的 Ovis2.5 包含两个不同参数规模的版本。首先是 Ovis2.5-9B,在 OpenCompass 评测中获得 78.3 的高分,超越了许多参数量更大的模型,并在 40B 以下参数规模的开源模型中排名第一。其次,Ovis2.5-2B 的综合得分为 73.9,延续了 Ovis 系列“小身板、大能量”的理念,特别适合端侧及资源受限的应用场景。

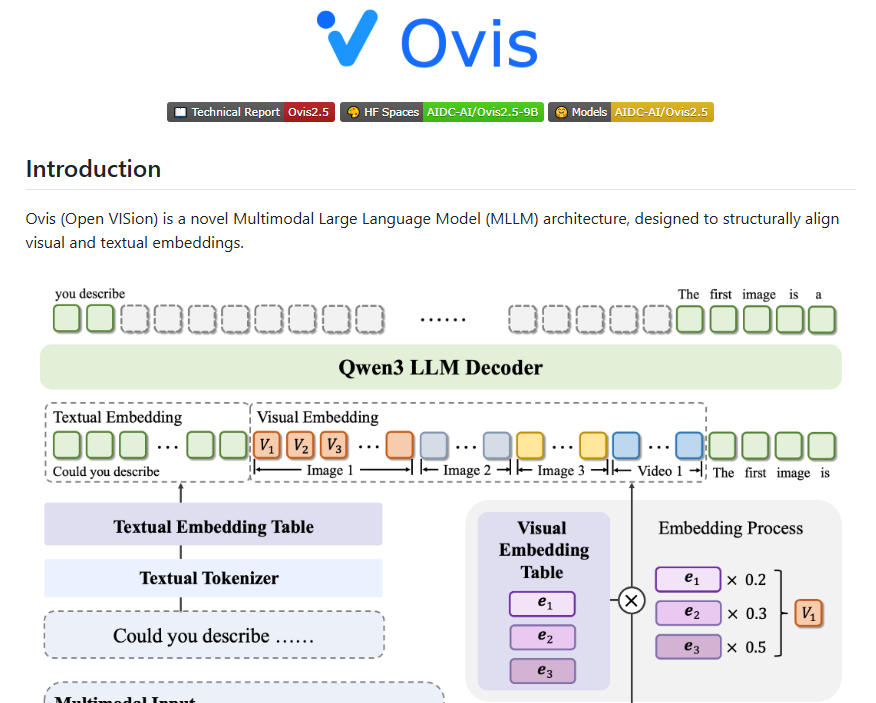

在 Ovis2.5 的整体架构上,官方进行了系统性创新,主要体现在模型架构、训练策略与数据工程三个方面。模型架构方面,Ovis2.5 延续了系列创新的结构化嵌入对齐设计,由三大核心组件构成:动态分辨率的视觉特征提取、视觉词表模块实现视觉与文本的结构对齐,以及以 Qwen3 为基础的强大语言处理能力。

在训练策略上,Ovis2.5 采用了更精细的五阶段训练方案,包括基础的视觉预训练、多模态预训练以及大规模的指令微调等多个步骤。同时,通过 DPO 和 GRPO 等算法加强偏好对齐和推理能力,有效提升了模型的性能。此外,模型的训练速度实现了 3 到 4 倍的端到端加速。

数据工程方面,Ovis2.5 的数据量相比 Ovis2 增加了 50%,重点聚焦于视觉推理、图表、OCR(光学字符识别)和 Grounding 等关键领域。特别是合成了大量与 Qwen3 深度适配的“思考”数据,极大地激发了模型的反思与推理潜能。

Ovis2.5 的代码和模型已在 GitHub 和 Hugging Face 等平台上线,用户可以通过这些平台获取相关资源,进一步探索其应用潜力。

划重点:

– Ovis2.5 在 OpenCompass 评测中取得 78.3 的综合得分,继续保持 SOTA 水平。

– Ovis2.5 包含两个版本,Ovis2.5-9B 适合大规模应用,Ovis2.5-2B 则专注于资源受限场景。

– 采用创新架构和训练策略,数据量增加 50%,聚焦视觉推理等关键领域。

(以上内容均由Ai生成)