苹果发布SlowFast-LLaVA模型,长视频理解性能超越大模型

快速阅读: 苹果研究团队发布SlowFast-LLaVA模型,优化长视频分析,双流架构提升处理效率,10亿至70亿参数版本表现优异,未来将优化内存技术。

苹果研究团队近日发布了适配版的SlowFast-LLaVA模型,该模型在长视频分析理解任务中表现出色,其性能甚至超越了参数规模更大的模型。这项突破为长视频内容分析提供了高效的全新解决方案。

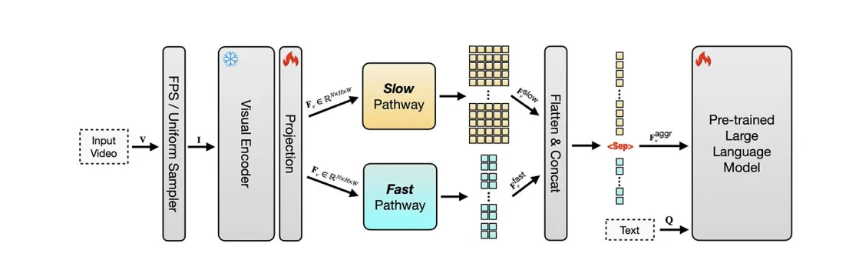

该模型的核心优势在于双流架构设计,有效解决了传统逐帧处理模式下的信息冗余和上下文窗口溢出问题。慢流以低帧率捕捉场景中的静态细节和背景信息,而快流则以高帧率追踪动作的快速变化。这种协同工作模式极大地优化了视频处理效率。

在长视频基准测试中,SlowFast-LLaVA展示了卓越性能。10亿、30亿和70亿参数版本均取得优异成绩。例如,10亿参数的模型在LongVideoBench的General VideoQA任务中获得56.6分,70亿参数版本在Long-Form Video Understanding任务中达到71.5分的高分。除了视频理解,该模型在知识推理和OCR等图像理解任务上同样表现出色。

尽管该模型表现出众,目前仍存在一些局限性,如输入帧长限制在128帧,可能导致关键信息的遗漏。苹果团队表示,未来将继续探索内存优化技术以提升模型性能。

SlowFast-LLaVA基于公开数据集训练并已开源,为AI社区在长视频理解领域提供了新的思路和高效工具。

(以上内容均由Ai生成)