InternLM推出8B参数轻量级多模态模型,刷新科技前沿

快速阅读: InternLM团队发布开源轻量级多模态推理模型Intern-S1-mini,参数8B,预训练超5万亿token,涵盖科学领域,具备解析复杂分子式、蛋白质序列能力,多项任务表现优异,支持“思考模式”,增强交互性,助力科研创新。

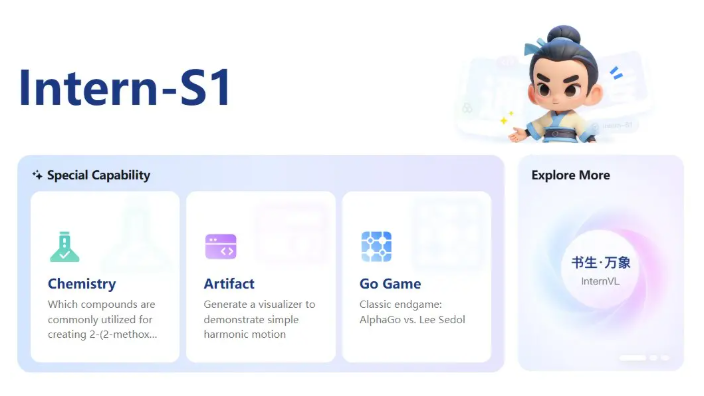

近日,InternLM团队发布了其开源的轻量级多模态推理模型——Intern-S1-mini。该模型参数仅为8B,结合了先进的Qwen3-8B语言模型和0.3B视觉编码器InternViT,展现出强大的处理能力和灵活性。

InternLM团队使用超过5万亿个token数据对Intern-S1-mini进行了大规模预训练,其中超过2.5万亿个token来自化学、物理、生物和材料等多个科学领域。这使Intern-S1-mini不仅能处理常规的文本和视觉输入,还能解析复杂的分子式、蛋白质序列,并有效规划合成路径,展示了其在科学研究领域的广泛应用潜力。

根据官方提供的基准测试结果,Intern-S1-mini在多个领域的任务表现均超过同类模型。在MMLU-Pro、MMMU、GPQA以及AIME2024/2025等任务上,该模型表现优异,ChemBench分数达到76.47,MatBench分数为61.55,ProteinLMBench则为58.47。这些成绩不仅证明了Intern-S1-mini的强大实力,还表明其在文本、图像和视频输入方面的兼容性。

有趣的是,Intern-S1-mini默认开启了“思考模式”,用户可以通过简单的开关命令(enable_thinking)来切换。这种设计增强了模型的交互性,为用户带来了更灵活的使用体验。

在科技飞速发展的今天,InternLM团队发布的Intern-S1-mini无疑为研究人员和开发者提供了一个新的工具,助力他们在多模态推理领域实现更多创新与突破。无论是在基础研究还是实际应用中,这一模型都将成为一个值得关注的焦点。

(以上内容均由Ai生成)