你有想象过喜欢的 UP 主说英语的样子吗?B 站上线 AI 原声翻译功能,基于自研模型

快速阅读: 8月4日,Bilibili Index团队推出“原声风格”视频配音功能,基于自研IndexTTS2模型,实现中文视频外语原声配音,提高音画一致性和沉浸感,计划支持更多语言并开源模型。

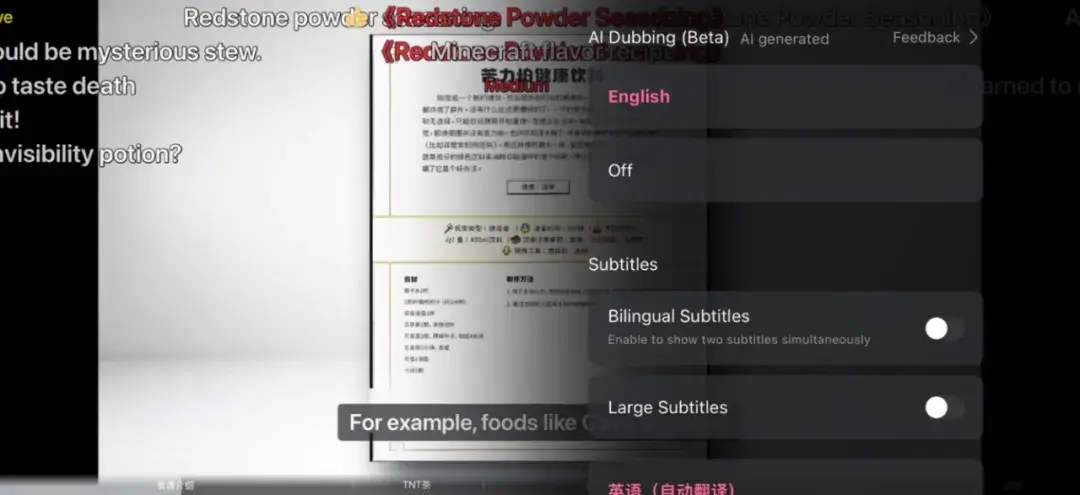

8月4日,Bilibili Index团队发布博文,宣布推出“原声风格”视频配音功能,该功能基于自研的IndexTTS2模型,能够将部分中文视频翻译为外语的原声风格配音。

此前,Bilibili曾介绍该功能上线,而在最新的博文中,团队详细介绍了背后的AI模型。通过自研模型,视频人物不再局限于单一的“代言人声线”,而是能够自然地用外语表达,声音、语气、节奏甚至个性都与原片高度一致,观众可以感受到“这个人用另一种语言在说话”。

BILIBILI IndexTTS2模型架构创新性地提出了适用于AR系统的“时间编码”机制,首次解决了传统AR模型难以精确控制语音时长的问题。这一设计不仅保留了AR架构在韵律自然性、风格迁移能力、多模态扩展性等方面的优势,还具备了合成定长语音的能力。

团队还利用音色克隆、声场一致性、多声源融合等技术,解决了传统配音中声音人格缺失、字幕干扰及本地化成本高等问题。系统针对多说话人场景优化了说话人分割、情绪迁移与语速控制,并引入RIVAL对抗式强化学习框架,提升翻译质量和风格适配度。

在视频层面,系统结合字幕擦除与基于Diffusion的高保真唇形同步,确保音画一致与沉浸感。B站表示,未来将支持更多语言,并计划开源模型,推动多语言、跨模态内容的全球化传播。

(以上内容均由Ai生成)