OpenAI开源GPT-OSS模型,116亿参数MoE架构引领AI新纪元

快速阅读: 近日,网络流传OpenAI将推出开源模型GPT-OSS,参数规模20亿至120亿,采用MoE架构,支持长上下文扩展,引发业界广泛关注。

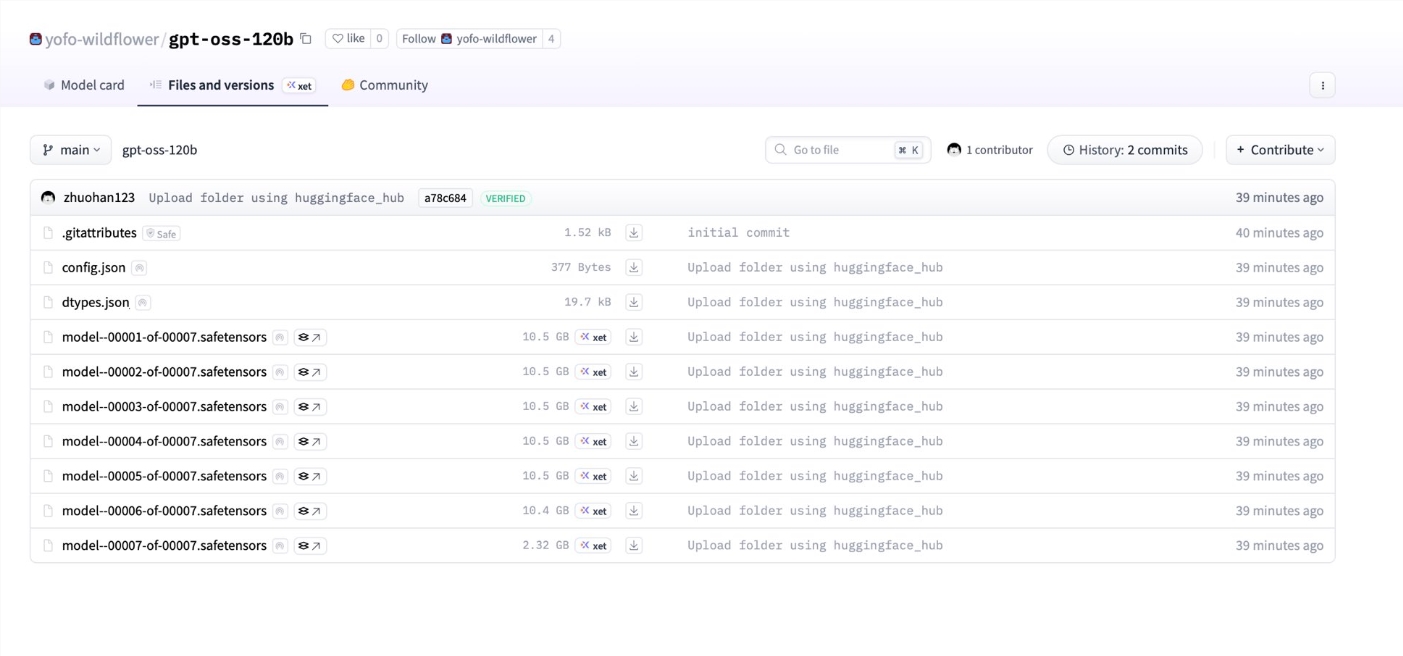

近日,网络上流传出OpenAI即将推出开源模型系列“GPT-OSS”(GPT Open Source Software)的重大信息泄露,引发业界广泛关注。据泄露的配置文件,这一操作系统系列模型参数规模从20亿到120亿不等,采用先进的MoE(Mixture of Experts)架构,结合长上下文扩展和高效注意力机制,展现出强大的性能潜力。AIbase编辑团队综合 最新 信息,为您深度解析GPT-OSS的技术亮点及其对AI行业的潜在影响。

MoE架构突破:116亿稀疏参数的强大引擎GPT-OSS系列模型采用Mixture of Experts(MoE)Transformer架构,包含36层、128个专家和Top-4路由机制,总稀疏参数高达116亿,活跃参数约5.1亿。这一设计通过将计算任务分配给多个专家模块,大幅降低了计算资源的消耗,同时保持了模型的高性能。相比传统密集模型,MoE架构使得GPT-OSS能够在更广泛的硬件环境下运行,为开源社区和开发者提供了更大的灵活性。核心技术亮点:高效MoE设计:128个专家模块通过Top-4路由选择 最优 专家处理任务,显著提升推理效率。

超大规模参数:总计116亿稀疏参数,活跃参数仅5.1亿,确保高效计算与强大性能的平衡。

灵活部署:MoE架构降低了对高性能GPU集群的依赖,使中小型团队也能利用这一模型进行开发。

长上下文扩展:131k Tokens的惊人能力GPT-OSS在上下文处理能力上实现了重大突破。其初始上下文长度为4096Tokens,通过RoPE(Rotary Position Embedding)技术扩展至约131k Tokens。这一长上下文能力使得模型能够处理超长文档和复杂对话场景,适用于学术研究、法律分析和大型代码生成等高吞吐场景。

此外,模型采用滑动窗口注意力机制(Sliding Window Attention),窗口大小为128Tokens,结合GQA(Grouped Query Attention)技术,每Token每层KV缓存占用仅约72KB。这种设计显著降低了内存开销,同时保持了高效的并行处理能力,为长文档处理提供了优异的性能保障。注意力机制优化:64头GQA与高吞吐性能GPT-OSS的注意力机制同样令人瞩目。

模型配备64个注意力头,每个头维度为64,结合GQA技术进一步优化了计算效率。相较于传统的多头注意力,GQA通过分组查询减少了计算复杂性,同时通过更宽的注意力投影(宽于隐藏维度)增强了模型容量。这种设计特别适合需要高吞吐量和低延迟的场景,例如实时翻译、代码补全和长文档生成。性能优势:GQA与滑动窗口结合:显著降低KV缓存的内存占用,提升解码效率。

NTK RoPE支持:通过非均匀时间感知的RoPE扩展,确保长上下文场景下的位置编码稳定性。

高吞吐优化:模型在解码侧具有优异的KV开销和并行特性,适合大规模生产环境。

开源战略的转折:OpenAI重回开放初心?OpenAI此次开源GPT-OSS的传闻被视为其战略的重大转变。作为一家近年来逐渐加强模型封闭性的公司,OpenAI此举可能是在回应开源社区的长期期待,同时对抗Meta和Mistral等竞争对手在开源AI领域的强势表现。据泄露信息,GPT-OSS系列包括多个版本(如20亿和120亿参数型号),显示出OpenAI有意打造一个覆盖不同需求的模型家族,为开发者提供更多选择。

然而,泄露的配置文件也引发了争议。部分开发者指出,116亿参数的MoE模型虽然在理论上强大,但实际运行可能需要高性能硬件支持。例如,运行120亿参数模型可能需要高达1.5TB的内存,这对普通开发者而言仍是一大挑战。

OpenAI尚未正式确认这些泄露信息的真实性,但业界普遍认为,开源GPT-OSS的发布将对AI生态产生深远影响。

AIbase观点: GPT-OSS的潜在影响与挑战GPT-OSS的泄露信息揭示了OpenAI在开源领域的新尝试,其MoE架构、长上下文扩展和高效注意力机制展示了下一代AI模型的技术趋势。通过降低计算门槛和优化内存使用,GPT-OSS有望为中小型开发者和研究机构带来更多创新机会。然而,模型的高硬件需求和未完全公开的训练细节可能限制其普及程度。未来,OpenAI如何平衡开源与商业化战略,以及如何优化模型的实际部署效果,将是业界关注的焦点。

结语 OpenAI GPT-OSS的泄露信息为我们揭开了下一代AI模型的神秘面纱,其强大的MoE架构和长上下文能力预示着AI技术的新篇章。AIbase将继续跟踪这一事件的后续进展,为您带来 最新 的科技资讯。敬请期待GPT-OSS的正式发布,以及它如何为开源AI生态注入新的活力!

(以上内容均由Ai生成)