阿里巴巴开源视频生成模型 通义万相 2.2,首推电影美学控制功能

快速阅读: 据相关媒体最新报道,阿里巴巴开源视频生成模型“通义万相 Wan2.2”,包含三种模型,采用MoE架构,提升生成效果与效率。支持文生视频、图生视频,可在消费级显卡部署。

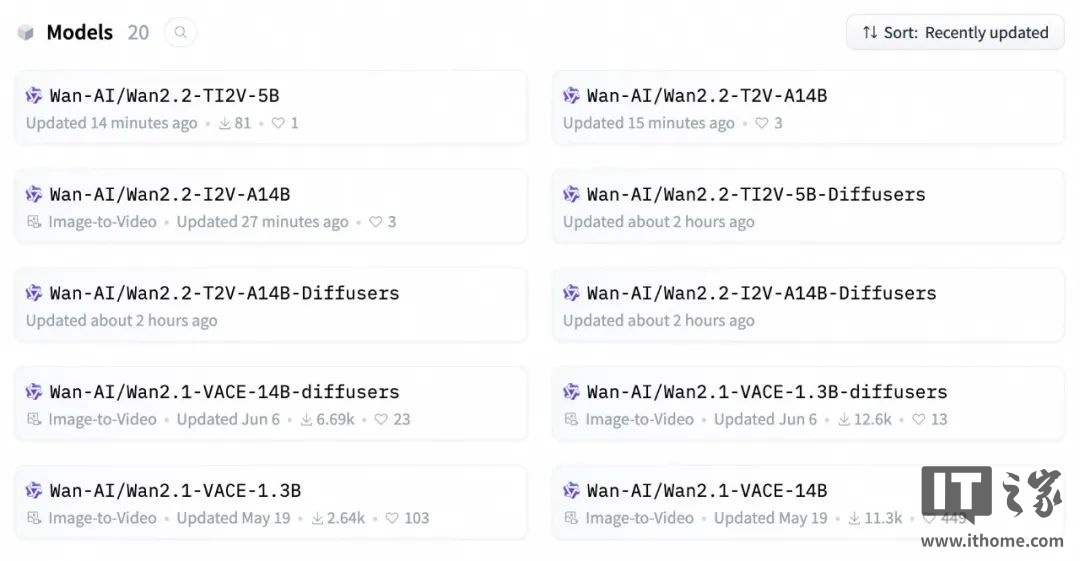

据阿里官方消息,7月28日晚,阿里巴巴宣布开源视频生成模型“通义万相 Wan2.2”。此次共开源了三种模型:文生视频(Wan2.2-T2V-A14B)、图生视频(Wan2.2-I2V-A14B)和统一视频生成(Wan2.2-IT2V-5B)。其中,文生视频和图生视频模型均为业界首次采用MoE架构的视频生成模型,总参数量达270亿,激活参数140亿。

开发者可以在GitHub、HuggingFace和魔搭社区下载模型及代码,企业用户可通过阿里云百炼调用API,普通用户也可通过通义万相官网或App直接体验。

通义万相2.2在视频生成扩散模型中率先引入MoE架构,解决了视频生成处理Token过长导致的计算资源消耗问题。这两款模型由高噪声专家模型和低噪专家模型组成,分别负责视频的整体布局和细节完善,在相同参数规模下,能节省约50%的计算资源。此外,该模型在复杂运动生成、人物交互、美学表达等方面也有显著提升。

特别值得一提的是,通义万相2.2还首创了“电影美学控制系统”,在光影、色彩、构图、微表情等方面达到了专业电影的水平。例如,用户输入“黄昏”、“柔光”、“边缘光”等关键词,模型就能自动生成金色落日余晖的浪漫画面;使用“冷色调”、“硬光”等组合,则能生成类似科幻片的效果。

此外,通义万相还开源了一款50亿参数的小尺寸统一视频生成模型,支持文生视频和图生视频,可在消费级显卡上部署。该模型采用了高压缩率3D VAE架构,时间与空间压缩比达到4×16×16,信息压缩率提升至64,是目前开源模型中压缩率最高的,仅需22G显存即可在数分钟内生成5秒高清视频。

自今年2月以来,通义万相已陆续开源多款模型,包括文生视频、图生视频、首尾帧生视频和全能编辑等,累计下载量已超过500万次。

(以上内容均由AI生成)