苹果AI报告:端侧内存减少37.5% 云端采用PT-MoE架构扩展多语言支持

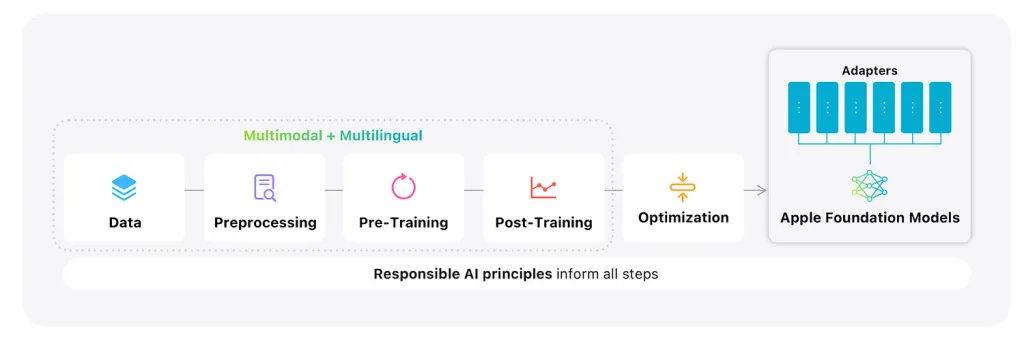

快速阅读: 据相关媒体报道,苹果发布《Apple Intelligence Foundation Language Models – Tech Report 2025》,介绍其AI模型的四大技术亮点:端侧双区块设计、云端PT-MoE架构、多语言支持提升及数据收集策略。

据科技媒体9to5Mac报道,7月21日,苹果公司发布了一份名为《Apple Intelligence Foundation Language Models – Tech Report 2025》的技术报告,深入探讨了苹果在AI领域的研究成果,涵盖了模型架构、数据来源、预训练等多个方面。

报告中揭示了苹果AI模型的四个关键技术点:

一是端侧模型采用双区块设计。苹果的端侧AI模型分为两个区块,第一区块包含约62.5%的Transformer层,第二区块包含约37.5%的Transformer层,但去除了键和值的映射。这种设计减少了约37.5%的内存需求,同时加快了第一个tokens的输出时间。

二是云端模型采用创新架构。苹果开发了一种名为Parallel-Track Mixture-of-Experts (PT-MoE)的架构,通过将大模型拆分为多个小的子网络,实现了模块化设计,提高了模型的响应速度和精度。

三是大幅提升了多语言支持。苹果增加了外语数据在训练中的比例,从8%提升至30%,并将标记器的容量增加了50%,使模型能够识别15万个不同的标记,显著增强了对多种语言的支持。

四是数据收集策略。苹果表示,如果出版商不同意其数据被用于训练,苹果将不会抓取这些数据。苹果强调,使用多样且高质量的数据对于训练模型至关重要,这些数据包括授权数据、公开数据集和通过Applebot抓取的公开信息。

(以上内容均由AI生成)