折叠尺可以告诉我们关于神经网络的什么

快速阅读: 《巴塞尔大学》消息,巴塞尔大学团队开发了一个简单模型,模拟深度神经网络的层级分工,通过弹簧-块理论理解数据分离机制,有助于优化AI训练。

深度神经网络是人工智能的核心,广泛应用于从模式识别到大型语言模型和推理模型如ChatGPT等任务。其原理是:在训练阶段,通过调整网络中人工神经元的参数,使其能够执行特定任务,例如自主地在图像中识别物体或特征。这种机制是如何运作的,以及为什么某些神经网络比其他神经网络更强大,仍然难以理解。目前的技术尚无法对这一过程进行严格的数学描述。然而,如果想要在资源有限的情况下构建人工智能,这种理解至关重要。

由巴塞尔大学数学与计算机科学系的伊万·多克曼尼奇教授带领的研究团队,近日开发出一个令人惊讶的简单模型,该模型可以再现深度神经网络的主要特征,并便于优化其参数。他们最近在科学期刊《物理评论快报》上发表了研究成果。

神经网络中的层级分工

深度神经网络由多个神经元层组成。当学习对图像中的对象进行分类时,网络会逐层逐步完成分类。在这个逐渐接近的过程中,两个类别——例如“猫”和“狗”——逐渐被清晰地区分,这被称为数据分离。“通常,在性能良好的网络中,每一层对数据分离的贡献大致相同,但有时主要由较深或较浅的层完成”,多克曼尼奇说道。

神经网络中的层级分工

这取决于网络的构造方式:神经元是否仅对输入数据进行线性运算(即专家所说的“线性”)?还是它们进行更复杂的计算——换句话说,网络是否为“非线性”?另一个考虑因素是:在大多数情况下,神经网络的训练阶段也包含随机性或噪声。例如,在每次训练中,随机选择的一组神经元会被忽略,无论其输入内容如何。令人意外的是,这种噪声反而能提升网络性能。

神经网络中的层级分工

“非线性与噪声的相互作用产生了极为复杂的行为,这很难理解和预测”,多克曼尼奇说。“另一方面,我们知道各层间数据分离的均衡分布有助于提升网络性能”。因此,为了取得一些进展,多克曼尼奇和他的合作者从物理理论中获得启发,开发出了一种可直观理解的学习过程宏观机械模型。

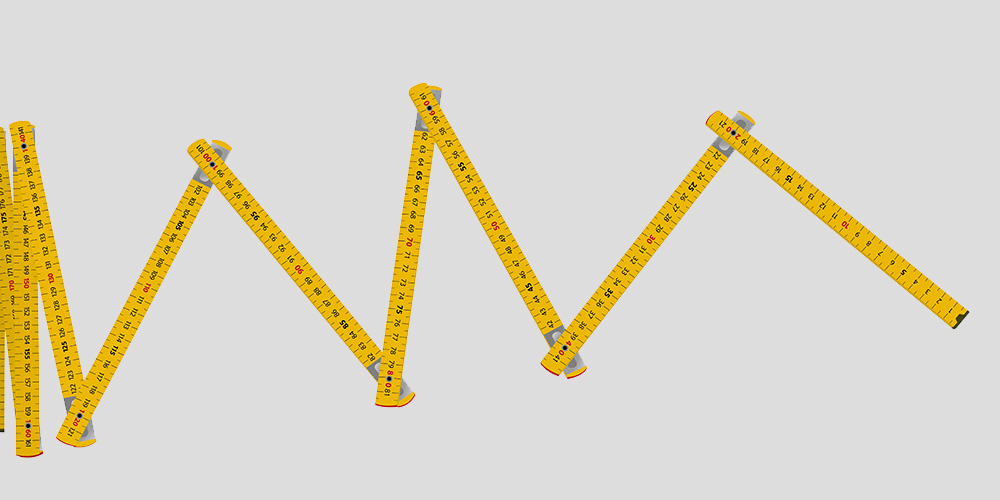

拉伸和摇动折叠尺

其中一个模型是一个折叠尺,其各个部分对应于神经网络的各层,并且在一端被拉开。在这种情况下,非线性来源于各部分之间的机械摩擦。可通过在拉伸过程中不规则地摇动折叠尺的一端来引入噪声。

这个简单实验的结果是:如果缓慢而稳定地拉伸尺子,前几段会展开,而其他部分则基本保持闭合。“这相当于数据分离主要发生在浅层的神经网络”,多克曼尼奇小组的博士生施成解释道,他是这项研究的第一作者。相反,如果快速拉伸并轻微摇动,折叠尺便会均匀展开。在网络中,这将是均匀的数据分离。

“我们已经模拟并数学分析了类似由弹簧连接的块模型,结果与‘真实’网络的结果几乎惊人地吻合”,施成说。巴塞尔的研究人员计划很快将他们的方法应用于大型语言模型。一般来说,这样的机械模型未来可用于改进高性能深度神经网络的训练,而无需依赖传统的试错法来确定噪声和非线性等参数的最佳值。

原始出版物

施成、潘立明、伊万·多克曼尼奇

深度神经网络中特征学习的弹簧-块理论

《物理评论快报》(2025),DOI: 10.1103/ys4n-2tj3

(以上内容均由Ai生成)