洞察聊天机器人产生幻觉、喷出虚假信息的原因

快速阅读: 《心灵很重要》消息,人工智能聊天机器人常因“自创事实”产生错误,如虚构的熊和宠物鸡。专家警告,这表明AI在复杂问题上仍有局限,应被视作辅助工具而非绝对权威。

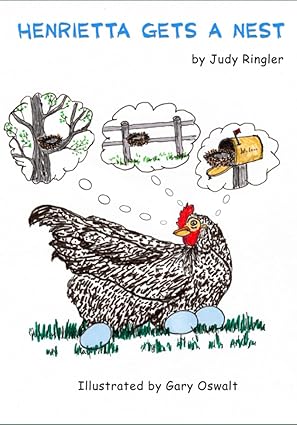

在他在Substack上的专栏中,人工智能分析师加里·马库斯分享了他对聊天机器人(即大型语言模型或LLMs)产生幻觉现象的看法。例如,当波莫纳学院的商业教授加里·史密斯询问ChatGPT俄罗斯是否曾经将熊送入太空时,他得到了一个既详尽又有趣的回答——然而,这个回答完全是虚构的,甚至列举了一些虚构的熊的名字。马库斯对这一问题并不陌生,因为在2023年,曾有一个机器人声称自己养了一只名为“亨丽埃塔”的宠物鸡。“如果我真的养一只宠物鸡,大概不会给它取名叫亨丽埃塔。”那么,为什么这些程序会输出完全错误的信息呢?他指出,自2001年起,他就一直在警告这个问题。他还补充道,当我们听到专家谈论人工智能会取代我们的工作时,我们应该牢记这一点。如果我们的工作是在已有正确答案的前提下依然胡编乱造,那么这些专家或许说得对;否则……

这种现象引发了更深层次的思考。人工智能虽然强大,但在面对复杂或模糊的问题时,常常会陷入“自创事实”的困境。就像那个虚构的“亨丽埃塔”,它更像是一个机器人的随意创作,而非真实存在的证据。这样的错误不仅令人哭笑不得,也提醒着人类:技术虽进步飞速,但距离真正理解世界和逻辑推理,还有很长一段路要走。

所以,当我们与这些强大的工具互动时,不妨多一些审视和质疑。毕竟,对于许多需要准确信息的工作来说,人工智能目前还远未达到完美无瑕的地步。与其盲目依赖,不如将其视为一种辅助工具,帮助我们更好地完成任务。这样,才能让科技真正服务于人类,而不是成为新的谜题制造者。

(以上内容均由Ai生成)