Nvidia 的液冷 AI 机架承诺 25 倍的能源和 300 倍的用水效率

快速阅读: 据《技术点》最新报道,随着AI计算需求增长,英伟达采用直接液体冷却系统解决高密度服务器散热问题。该系统通过冷板冷却GPU和CPU,使用闭路液体循环显著降低能耗和水耗。尽管架构复杂且需改造数据中心,但性能提升促使更多运营商推进液冷改造。

当前趋势:随着人工智能和高性能计算不断推动对日益强大的数据中心的需求,行业面临一个日益严峻的挑战:如何在不消耗不可持续的能源和水资源的情况下冷却越来越密集的服务器机架。传统的风冷系统,在早期服务器硬件时代曾足够使用,但现在难以应对现代AI基础设施产生的高强度热输出。这一转变在英伟达最新推出的系统中尤为突出。该公司的GB200 NVL72和GB300 NVL72机架级系统代表了计算密度的重大飞跃,每个机架可容纳数十块GPU和CPU,以满足万亿参数AI模型和大规模推理任务的性能需求。但达到这种性能水平的成本非常高昂。虽然典型的数据中心机架耗电在7到20千瓦之间(高端GPU机架平均为40到60千瓦),英伟达的新系统每机架需要的电力是传统配置的七倍以上。这种功率密度的急剧上升使得传统的风冷方法对于这样的高性能集群来说已经不够用了。空气无法迅速带走热量,导致过热,特别是当机架变得越来越紧凑时。

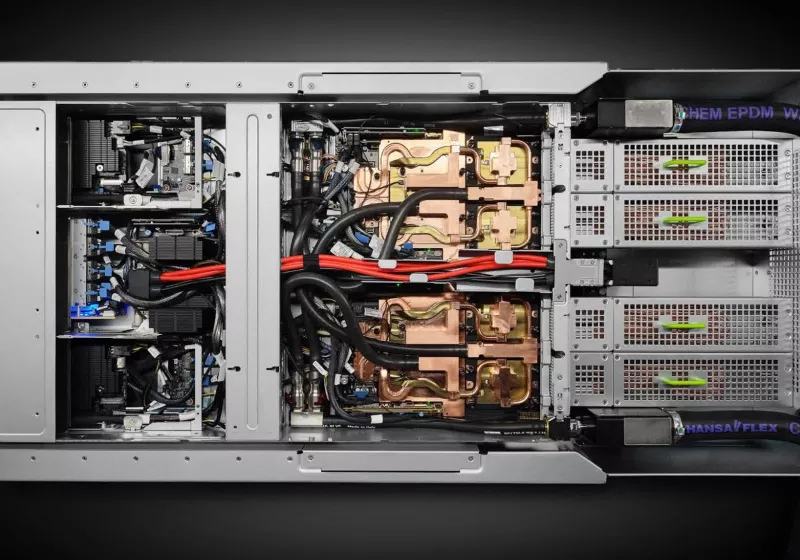

为了解决这个问题,英伟达采用了直接到芯片的液体冷却系统——一种通过直接安装在最热部件(如GPU和CPU)上的冷板循环冷却剂的系统。这种方法比空气更有效地转移热量,使配置更加密集和强大。与传统的蒸发冷却不同,后者消耗大量水来冷却空气或循环的数据中心内的水,英伟达的方法使用闭路液体系统。在这种设置下,冷却剂连续循环通过系统而不蒸发,几乎杜绝了水损耗,大幅提升了用水效率。

这些系统的架构非常复杂。通过机架级液-液热交换器将冷却剂吸收的热量传递至设施的更广泛的冷却基础设施,即冷却剂分配单元(CDUs)。这些CDUs由CoolIT和Motivair等合作伙伴开发,具备最高达两兆瓦的冷却能力,支持高密度机架产生的巨大热负荷。此外,温水冷却减少了对机械制冷设备的依赖,进一步降低了能耗和水的使用量。

这些系统的架构非常复杂。通过机架级液-液热交换器将冷却剂吸收的热量传递至设施的更广泛的冷却基础设施,即冷却剂分配单元(CDUs)。然而,转向直接液体冷却带来了挑战。数据中心传统上是以模块化和服务性为目标建造的,使用热插拔组件进行快速维护。全封闭式液体冷却系统让这一模式变得更加复杂,因为打破密封更换服务器或GPU可能会危及整个回路。这些系统的架构非常复杂。通过机架级液-液热交换器将冷却剂吸收的热量传递至设施的更广泛的冷却基础设施,即冷却剂分配单元(CDUs)。为了减轻这些风险,直接到芯片的系统使用快速断开连接件,兼顾了可维护性和防漏效果。

尽管如此,大规模应用液体冷却技术通常需要对数据中心的物理基础设施进行全面改造,需要大量的前期投资。尽管存在这些障碍,由Blackwell驱动的英伟达系统的性能提升促使运营商推进液体冷却改造项目。英伟达与施耐德电气合作开发了参考架构,加快高密度液冷集群的部署进程。这些设计集成了CDU并采用先进热管理方案,支持每机架高达132千瓦。

(以上内容均由Ai生成)