加沙和 AI 战争

快速阅读: 据《黎明》最新报道,调查揭露,以色列利用人工智能系统“薰衣草”在加沙地带实施大量非战斗人员伤亡。文章批评科技巨头与以色列军方合作推动数字种族隔离和机械化杀戮,质疑责任归属并呼吁国际社会阻止算法战争的全球化。

去年十月的一个深夜,加沙地带的一个家庭在以色列军方所谓的“精准打击”中被彻底摧毁。没有预警,也没有任何传统战争的其他元素。仅仅依靠一个算法,作为名为“薰衣草”的人工智能系统的一部分,扫描元数据,将该地点标记为威胁,并从天而降引发致命打击。

调查显示,“薰衣草”系统对超过三万七千名巴勒斯坦人进行了潜在目标标记,通常缺乏或根本没有人工验证,其中相当大一部分是非战斗人员。但这并没有阻止系统以冷酷、无情且“高效”的方式运行。欢迎来到目前在加沙地带进行测试的未来战争形式,在这里,战斗决策由代码和冷冰冰的逻辑处理,不再受到良心或法律的制约。

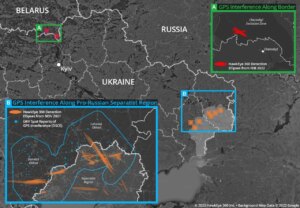

以色列长期以来一直自夸其军队是世界上最先进的之一,而随着人工智能(AI)如今已融入其占领体系之中,它已经占据了领先地位,这应该让我们所有人都感到恐惧。从约旦河西岸的人工智能驱动的监控塔和面部识别检查站,到加沙地带的自主无人机和预测性杀戮名单,以色列军队更多地将人工智能视为执行者而非辅助工具。

据以色列情报官员透露,“薰衣草”系统使用模式识别、面部数据和数字足迹来识别疑似哈马斯成员。一旦被标记,个人的住所可能在数分钟内遭到轰炸,通常是在儿童和亲属最有可能在场的时候。在许多情况下,无需验证被标记的人是否积极参与战斗或构成任何直接威胁。打击决定由依赖系统“高成功率”的初级军官盖章批准,而不是基于实际情报。

以色列的人工智能军事化与全球科技产业深度交织。讽刺的是,那些宣扬遵循伦理人工智能原则的大科技公司,实际上正在推动地球上一些最为先进的数字种族隔离和机械化杀戮系统。例如,亚马逊云服务(AWS)和谷歌共同参与了“尼姆布斯”项目,这是一个价值十二亿美元的以色列政府云计算合同,为数据处理和人工智能操作提供支撑。这些公司宣称该项目排除了军事用途,但告密者和专家对此表示严重怀疑,指出在一个高度军事化的国度里,民用和军事数据之间的界限模糊不清。

加沙地带成为了理想的试验场。这片人口密集、被围困的土地上,两百万包括儿童在内的巴勒斯坦人生活在永久监视和反复轰炸之下,他们的行动、对话和点击被一个将他们转化为数据点的政权收集。以色列对基于人工智能的战争实验比偶然事件更具结构性。被占领、封锁的领土提供了无监管的环境,如果在世界其他地区的平民身上测试这些技术,将会造成人间地狱。

后果极为惨烈。人工智能驱动的打击导致现代冲突中平民死亡人数最高之一。整个住宅楼依据“数据模式”被夷为废墟。以色列军方称其为外科手术式打击,但死亡人数和目击者证词讲述了一个不同的故事。人工智能冰冷、临床的语言让以色列军方能够掩盖暴力行为为客观现象。我们被告知算法不是政治性的,但它们是基于由占领、偏见及多年非人化塑造的数据训练出的。在加沙,这种偏见似乎已被人工智能主动强化。

可以安全地假设,当机器推荐目标,人类仅需简单点击“确认”时,问责制已经崩溃了。责任归于谁?开发者、信任它的军官、从中获利的技术公司还是资助它的政府?在现行法律空白下,无人承担责任。国际法同样准备不足,甚至可能已被边缘化。日内瓦公约和其他规范战争法的框架围绕着人类决策、比例性和问责制构建。但当战争由做出概率猜测的机器发动时会发生什么?

关于致命自主武器系统(LAWS)尚无具有约束力的国际条约。然而,联合国秘书长呼吁在2026年前达成一项具有法律效力的协议,旨在禁止没有有意义的人类监督的LAWS。与此同时,以色列几乎享有完全的免责权。尽管美国对先进计算芯片和部分AI模型采取了一些出口管制措施,但这些远远不足以监管目前在加沙地带用于军事行动的双重用途技术。对于提供后续用于目标监视或算法战争的基础设施的公司,没有任何有效的惩罚措施。监管机构继续在理论上倡导伦理AI框架,但在执行方面保持沉默,尤其是在违反行为被披上国家安全或外交政策外衣时。

不出所料,这种沉默对所有相关方都有利可图。当以色列公司将其AI工具标榜为“经过实战检验”时,它们赢得了其他希望采用类似手段的政府支持。因此,我们正在见证算法战争的全球化,巴勒斯坦人成为第一批受害者。

那么问题不再仅仅是道德上的。当机器被赋予决定生死的权利,对算法“预测”的合理化灭绝理由是什么?人工智能的军事化不仅威胁巴勒斯坦人,也威胁我们所有人。一旦机器被允许决定谁生谁死,世界上其他国家离成为下一个战场只有几个数据集的距离。今天在加沙完善的技术系统很可能很快会被部署到难民营、城市抗议活动或其他战区。

如果世界继续保持沉默,人工智能的军事化必将走向工业化。

作者是Media Matters for Democracy的创始人。发表于《黎明报》,2025年4月26日。

(以上内容均由Ai生成)