Nvidia 发布 NeMo 微服务以简化 AI 代理开发

快速阅读: 据《福布斯》最新报道,英伟达推出Nemo微服务通用版,帮助企业构建与业务系统集成并持续改进的AI代理工具。该工具包包含五大微服务,支持多种AI模型。相比竞争对手,它通过与硬件生态整合及企业级支持脱颖而出。这对技术团队简化AI实施、保持数据准确性至关重要,标志着企业AI工具成熟度提升。

英伟达发布Nemo微服务通用版本

为企业提供构建与业务系统集成且通过数据交互持续改进的AI代理工具

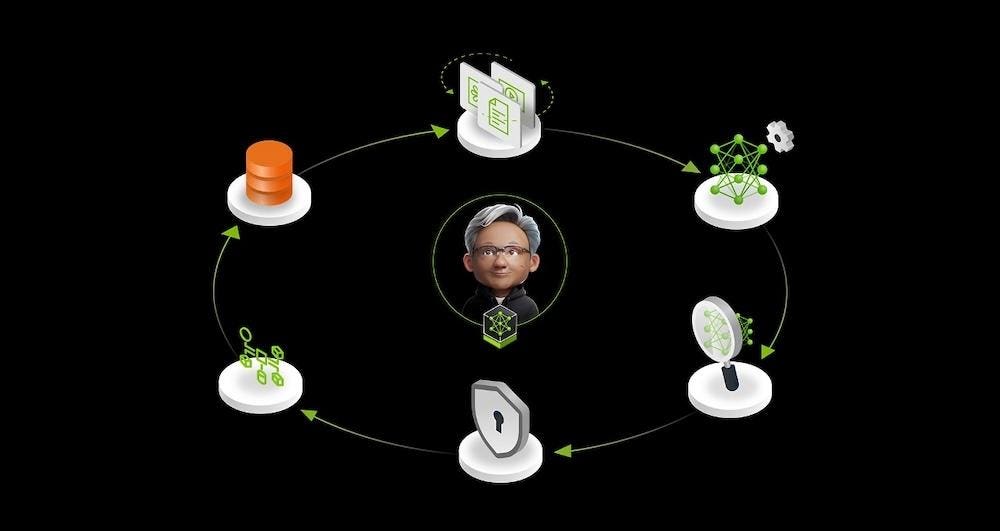

企业AI正面临数据集成难题:构建能够从商业数据中不断学习以保持准确性和实用性的系统。Nemo微服务通过创建英伟达所描述的“数据飞轮”,使AI系统通过持续接触企业信息和用户互动保持相关性,从而解决这一问题。

新发布的工具包包含五个关键微服务:

**Nemo定制器**

处理大型语言模型微调,具有更高的训练吞吐量。

**Nemo评估器**

提供简化评估AI模型的自定义基准。

**Nemo护栏**

实施安全控制以确保合规性和适当响应。

**Nemo检索器**

在企业系统间实现信息访问。

**Nemo策展人**

处理并组织数据用于模型训练和改进。

这些组件协同工作以构建AI代理,作为数字队友,能够在较少人类监督下执行任务。与普通聊天机器人不同,这些代理可根据企业数据自主行动并做出决策。它们连接到现有系统以获取组织边界内的当前信息。

技术支持持续优化

Nemo与英伟达推理微服务(简称NIMs)的区别在于它们的功能互补。据英伟达企业生成式AI软件高级总监乔伊·康威所说:“NIMs用于推理部署——运行模型、输入问题、输出答案。Nemo专注于如何改进该模型:数据准备、训练技术、评估。”当Nemo完成模型优化后,可通过NIM进行生产部署。

早期实施展现了实际的商业价值。通信软件提供商爱德科斯利用Nemo微服务开发了三个专用代理。AT&T与Arize和Quantiphi合作构建了一个每周处理约1万份文档更新的代理。思科的Outshift部门与伽利略合作创建了一个编码助手,比同类工具更快响应。

这些微服务以Docker容器形式运行,并通过Kubernetes编排,可在各种计算环境中部署。它们支持包括Meta的Llama、微软的Phi系列、谷歌的Gemini和Mistral在内的多种AI模型。英伟达自家专注于推理能力的Llama Nemotron Ultra也与此系统兼容。

此次发布进入了竞争激烈的市场,企业有众多AI开发选项。替代方案包括亚马逊的Bedrock、微软的Azure AI Foundry、谷歌的Vertex AI等。英伟达通过与自身硬件生态系统的整合以及通过AI Enterprise软件平台提供企业级支持来区别于其他产品。

Nemo微服务与企业AI采用

对于技术团队而言,这些微服务提供了降低实施复杂性的基础设施。容器化方式可在本地或云环境中部署,并具有企业安全和稳定性功能。这种灵活性解决了AI实施中常见的数据主权和监管合规问题。

评估这些工具的组织应考虑其现有的GPU基础设施投入、数据治理需求以及与现有系统的集成需求。需要保持对变化商业数据准确性要求的AI代理将推动对支持持续学习周期的平台的需求。

微服务方法体现了行业向模块化AI系统的更广泛转型,这些系统可在不重建基本组件的情况下针对特定业务领域进行定制。对于技术决策者来说,这次发布代表了企业AI工具成熟度的又一步骤,缩小了研究能力与实际业务应用之间的差距。

随着企业超越实验阶段迈向生产AI系统,简化构建持续改进模型的工具变得越来越有价值。“数据飞轮”概念体现了一种架构模式,其中AI系统通过持续接触组织信息保持与业务需求的对齐。微服务方法体现了行业向模块化AI系统的更广泛转型,这些系统可在不重建基本组件的情况下针对特定业务领域进行定制。对于技术决策者来说,这次发布代表了企业AI工具成熟度的又一步骤,缩小了研究能力与实际业务应用之间的差距。

(以上内容均由Ai生成)