新的 AI 基准测试测试 AI 应用程序的运行速度

快速阅读: 据《塞浦路斯邮政》最新报道,开源组织MLCommons发布两项新基准测试,评估AI硬件和软件性能。英伟达新款服务器大幅提升速度,AMD未参与大规模测试。这些测试助力AI行业优化硬件与软件协作,促进技术进步。

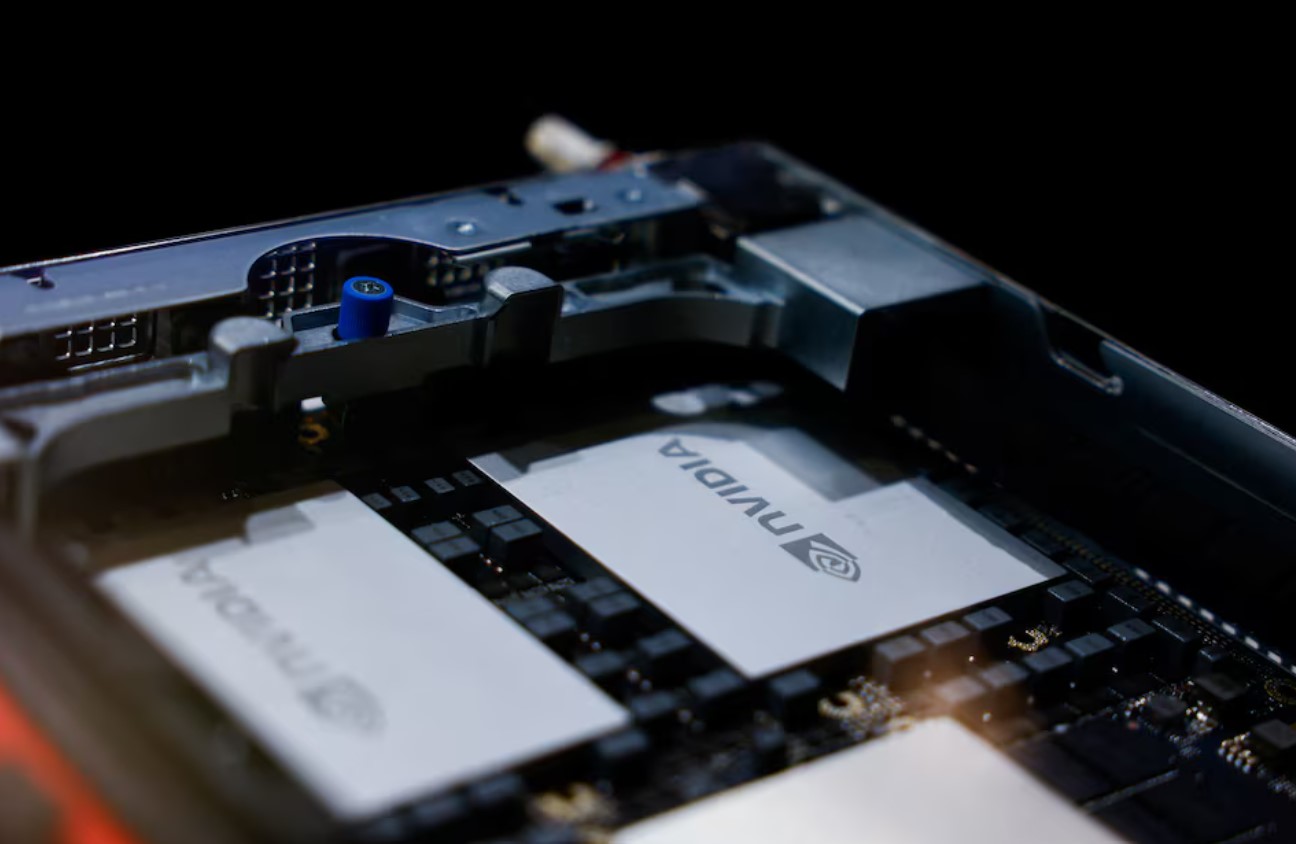

开源人工智能联盟**MLCommons**发布了两项新的基准测试,声称这些测试能够帮助评估顶级硬件与软件运行AI应用程序的速度。

自两年前**OpenAI**推出**ChatGPT**以来,芯片公司逐渐将重点转向开发能够高效运行供数百万用户使用的AI工具的硬件。随着底层模型需要处理更多的查询以支持聊天机器人、搜索引擎等AI应用,**MLCommons**开发了**MLPerf**基准测试的两个新版本,以衡量速度表现。

其中一项新基准测试基于**Meta**推出的所谓**Llama 3.1**(拥有4050亿参数)的大型AI模型,测试内容聚焦于通用问答、数学以及代码生成。这种新形式的测试旨在评估系统处理大规模查询并整合多源数据的能力。

在这项测试中,**英伟达**提交了多款芯片,包括其最新的**Grace Blackwell**人工智能服务器,该服务器内置72颗**英伟达GPU**。即使仅用这款新服务器中的八块GPU进行对比,其运行速度也比上一代提升了2.8至3.4倍,这一结果由公司于周二的简报会上公布。为了提升服务器内部芯片之间的通信效率,**英伟达**一直在积极优化相关技术,这对于AI任务至关重要,因为聊天机器人通常需要同时在多个芯片上运行。

第二项基准测试同样基于**Meta**构建的开源AI模型,其目标是更贴近消费级AI应用(例如**ChatGPT**)的实际性能预期。这项测试旨在大幅缩短基准测试的响应时间,使其接近实时响应。

根据**MLCommons**提供的信息,在这项测试中,并未发现**Advanced Micro Devices**(AMD)提交了针对这一4050亿参数大规模基准测试的芯片。

通过这两项新基准测试,AI行业得以进一步明确硬件与软件协同工作的最优解,从而推动未来AI技术的快速发展。

(以上内容均由Ai生成)