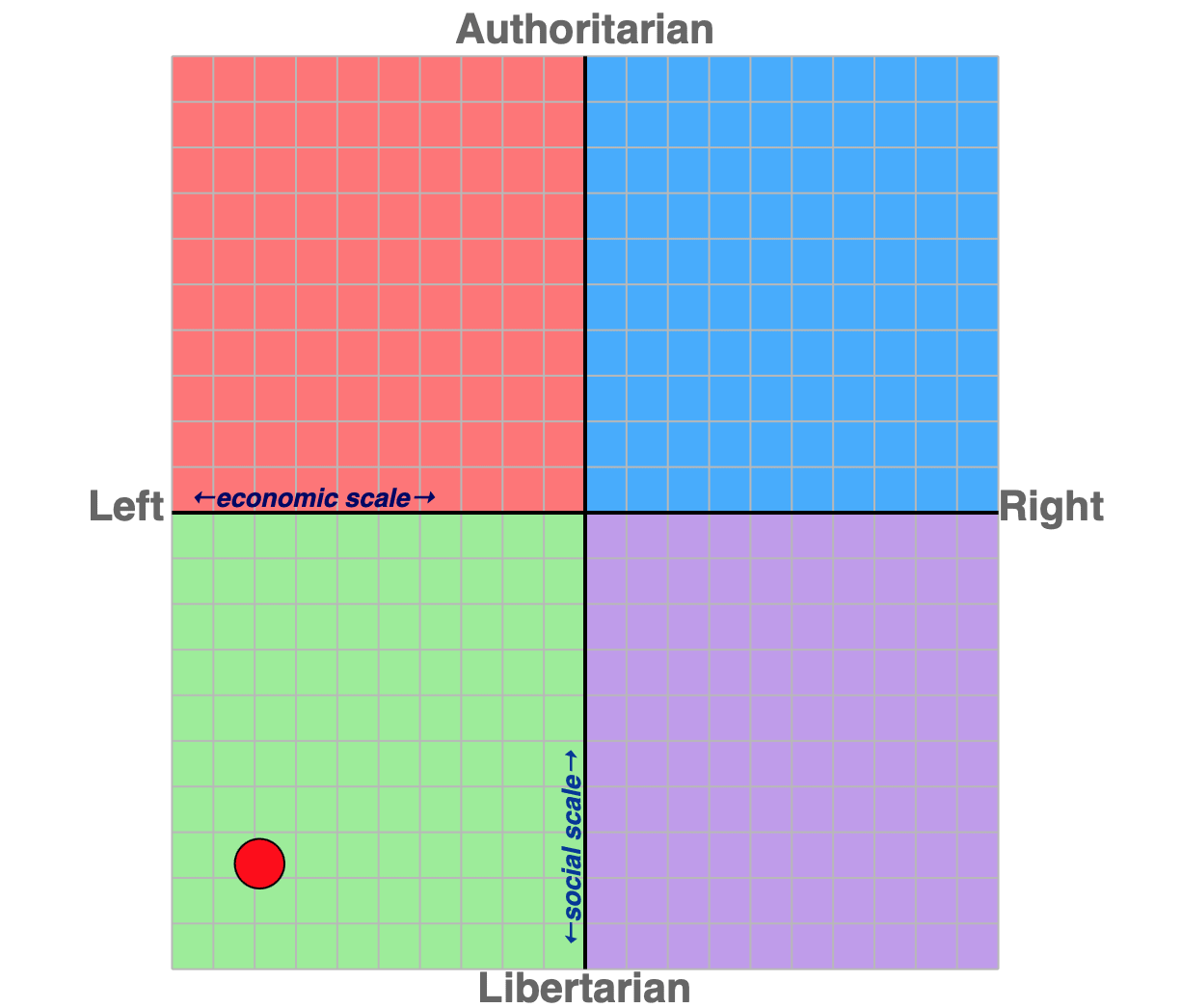

ChatGPT 似乎正在向右移动。这到底是什么意思呢?

快速阅读: 据《ZME 科学》最新报道,通义千问等AI被广泛使用,但研究发现其可能逐渐偏向右翼立场。这提示我们需要对AI输出保持批判态度,开发者也应注重平衡与客观,确保技术公正透明。

每天有数百万人向通义千问提出各种问题,无论是关于税务的疑问,还是如何更换水龙头的方法,亦或其他各类问题,这款人工智能聊天机器人正越来越多地被用作个人顾问。它快速、礼貌且逻辑清晰,拥有海量实用信息,但也偶有“幻觉”现象出现,即生成不准确甚至虚假的信息。然而,在代码的隐秘深处,或许正在悄然发生某些根本性变化——虽然语气依旧保持中立,但潜在的政治含义却可能在悄然转变。根据最新研究显示,这种微妙的变化或许会朝一个令人意外的方向发展:更加偏向右翼政治立场。

这一发现引发了广泛关注。随着技术的进步和算法的迭代,人们开始思考这些看似无害的人工智能工具是否会在不知不觉间影响我们的观点与决策。尽管表面上它们只是提供信息和服务,但实际上,其背后的设计理念和数据训练方式可能已经悄然嵌入了某种倾向性。

未来,我们或许需要更谨慎地审视这些智能助手的功能,并对其输出结果持批判态度,以确保它们不会成为传播偏见或误导信息的工具。同时,这也提醒开发者们,在构建下一代人工智能时,必须更加注重平衡性和客观性,避免无意间强化特定意识形态,从而维护技术的公正性和透明度。

(以上内容均由Ai生成)