是什么让 AI 更智能?语言模型训练内幕

快速阅读: 据《黑客 Noon》称,本文探讨了一种选择性状态空间模型(SSM),通过引入选择机制优化模型结构与性能。研究在多种任务上评估了模型表现,包括语言、DNA和音频建模,并分析了不同架构和训练方法的影响。文章提供了详细的实验细节及消融研究,强调扩展状态维度的重要性。研究已发布于arXiv,遵循CC BY 4.0许可。

摘要与引言

2 选择性状态空间模型

3 选择性状态空间模型与

2 选择性状态空间模型

3.1 动机:选择作为压缩手段

3.2 利用选择改进SSMs

3.3 选择性SSMs的有效实现

3.2 利用选择改进SSMs

3.4 简化版SSM架构

3.2 利用选择改进SSMs

3.5 选择机制的特性

3.6 模型的其他细节

4 实验评估

4.1 合成任务

4.2 语言建模

4.3 DNA建模

4.4 音频建模与生成

4.5 速度与内存基准测试

4.6 模型消融研究

5 讨论

6 结论、致谢与参考文献

A 讨论:选择机制

B 相关工作

B.1 S4变体与衍生品

B.2 SSM架构

B.3 与RNN的关系

B.4 线性注意力

B.5 长上下文模型

C 选择性SSMs的机制

D 针对选择性SSMs的硬件感知算法

E 实验细节与附加结果

E.1 合成任务

E.2 语言建模

E.3 DNA建模

E.4 音频细节

E.5 效率基准

E.2 语言建模

E.2.1 规模定律细节

所有模型均在The Pile上进行了训练。

模型大小。

表12指定了我们用于规模定律的模型大小。这直接取自GPT3规范(Brown等,2020),仅有非常小的修改。首先,我们将1.3B模型的批量大小从1M tokens更改为0.5M tokens,因为我们没有使用足够的并行化来需要更大的批量大小。其次,我们将训练步数和总令牌数量大致调整为匹配Chinchilla规模定律(Hoffmann等,2022),该定律规定训练令牌应按比例增加到模型大小。

训练配方。

所有模型均使用AdamW优化器,

• 梯度裁剪值为1.0

• 权重衰减为0.1

• 没有dropout

• 带余弦衰减的线性学习率预热

默认情况下,峰值学习率为GPT3规范。

我们给几个模型一个“改进配方”,灵感来自PaLM(Chowdhery等,2023)和LLaMa(Touvron等,2023)等流行大型语言模型所采用的更改。这些包括:

架构与训练细节。

我们的模型是:

• Transformer:基于GPT3的标准Transformer(表12)。

• Transformer++:具有改进架构的Transformer,即旋转位置编码(Su等,2021)和SwiGLU MLP(Shazeer,2020),以及上述改进的训练配方。

• Hyena:在标准MLP块之间插入Hyena块(用由MLP参数化的全局卷积替换S4的H3块)。MLP块的扩展因子为2而不是4,并且层数相应地增加了1.5倍以保持参数计数。

• H3++:H3架构的一些修改,包括(i)使用相同的“薄”Hyena维度(ii)上述改进的训练配方(iii)线性注意力头维度为8。

• RWKV:B. Peng等(2023)的默认RWKV模型,包括其修改后的MLP块。我们也尽可能多地使用了其指定的训练配方,例如在某些参数上将学习率提高2倍或3倍。

• RetNet:Y. Sun等(2023)的默认RetNet模型。我们还给了它上述改进的训练配方。

• Mamba:标准Mamba架构,带有改进的训练配方。

E.2.2 其他规模定律消融研究

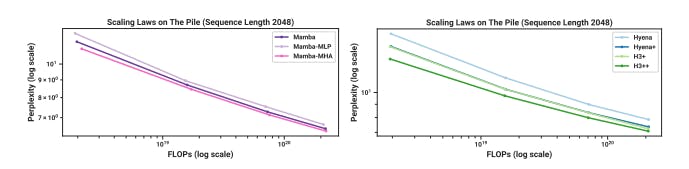

我们在图4(左)中2k上下文长度规模定律的相同协议下对架构进行额外消融。

Mamba架构:

交错块。我们测试了与Mamba块结合的不同架构块的效果。我们重点关注Mamba块只是标准SwiGLU块加上额外添加的路径这一观点。这导致了两个自然的消融:

• 如果Mamba块与标准MLP块交错,而不是同质堆叠?这也可被解释为取Mamba并移除一半的SSM。

• 如果Mamba块与MHA(多头注意力)块交错?这也可被解释为取一个具有SwiGLU MLP的Transformer(即我们所说的Transformer++)并简单地向MLP块添加SSM。

图9(右)显示了这些变体与原始(同质)Mamba架构相比的结果。有趣的是,这两种变化影响都不大。Mamba-MLP架构略差一点,但仍优于除Transformer++之外的所有模型。Mamba-MHA架构略好一点,在考虑到许多最近的工作发现结合(LTI)SSM与注意力可以带来显著改进的情况下有些令人惊讶(Dao、Fu、Saab等,2023;Fathi等,2023;Fathullah等,2023;Saon、Gupta和Cui,2023;Zuo等,2022)。

• 如果Mamba块与MHA(多头注意力)块交错?这也可被解释为取一个具有SwiGLU MLP的Transformer(即我们所说的Transformer++)并简单地向MLP块添加SSM。

H3架构:

训练配方。接下来我们消融Hyena和H3++模型之间的差异,我们的最弱和最强模型(不包括Transformer++和Mamba),特别是为了隔离训练配方的影响。

• Hyena:具有原始架构和GPT3训练配方的Hyena块(与图4相同)。

• Hyena+:相同的架构但使用上述改进的训练配方。

• Hyena:具有原始架构和GPT3训练配方的Hyena块(与图4相同)。

• H3+:与Hyena+相同的架构,但用S4D卷积核替换了Hyena卷积核。

• H3++:与H3+相同,但线性注意力头维度为8。这增加了SSM递归内部的计算,但不增加参数。

我们的一般惯例是,“Model+”代表基础模型加上改进的训练配方,“Model++”也允许进行架构更改。

图9(右)显示了以下内容:

• 改进的训练配方带来了很大的提升,这是主图4中的许多模型所使用的(RetNet、H3++、Transformer++、Mamba)。

• 内部LTI SSM的选择无关紧要(例如Hyena与S4),这与本文中的发现一致。

• 头维度扩展提高了性能,这与我们的主要主题之一一致,即扩展状态维度可以提高SSM的性能(第3节)。

E.2.3 下游评估细节

此预训练过程与规模定律协议相同,但延长至300B tokens。对于1.3B模型,我们使用1M tokens的批量大小以符合GPT3规格。我们报告Pile验证集上的困惑度,并仅将此指标与其他在同一数据集上训练且使用相同标记器的模型进行比较,特别是Pythia和RWKV。

对于下游评估,我们使用EleutherAI的LM评估工具箱(L. Gao、Tow等,2021),这是该领域大多数工作的做法。我们在以下衡量常识推理的任务/数据集上进行评估:

• LAMBADA(Paperno等,2016)。

• HellaSwag(Zellers等,2019)。

• PIQA(Bisk等,2020)。

• ARC挑战(P. Clark等,2018)。

• ARC-easy:ARC挑战的一个简单子集。

• ARC挑战(P. Clark等,2018)。

• WinoGrande(Sakaguchi等,2021)。

我们报告LAMBADA、WinoGrande、PIQA和ARC-easy的准确率,以及HellaSwag和ARC挑战的序列长度归一化准确率(因为对于这些任务,几乎所有模型的归一化准确率都更高)。

本文可在arxiv上获得

根据CC BY 4.0条款授权。

(以上内容均由Ai生成)