Google 将 Gemini 2.0 的多模态功能引入机器人技术

快速阅读: 据《药物发现与开发》最新报道,英伟达推出“世界基石模型”Cosmos,谷歌升级Gemini 2.0为Gemini Robotics,实现“视觉-语言-动作”功能。Gemini Robotics具备通用性、交互性和灵巧性,能处理复杂任务。谷歌加强安全措施,确保机器人行为符合规则。多家科技巨头也在推进具身人工智能发展,强化学习技术持续进步。

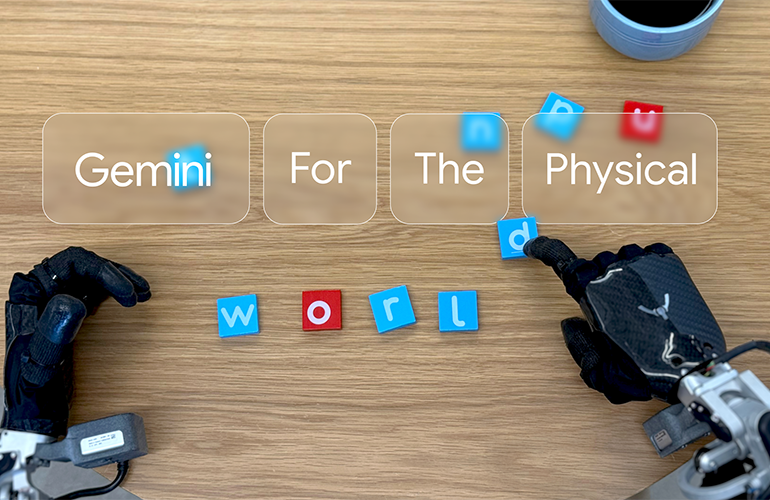

今年早些时候,英伟达推出了号称“世界基石模型”的Cosmos,这款模型将人工智能引入现实世界。英伟达首席执行官黄仁勋称其为:“人工智能的下一个前沿是物理人工智能。”如今,谷歌也在这一人工智能与机器人合成领域取得了新进展。谷歌在其多模态基础模型Gemini 2.0的基础上进一步升级,这个模型最初专注于文本和图像处理,并通过增加物理操作作为新的输出模式得以实现。Gemini Robotics能够借助摄像头和传感器观察并理解世界,它能读取或听取自然语言指令,随后通过生成低级机器人控制命令来执行这些指令。这使得它成为一种“视觉-语言-动作”(VLA)模型。按照谷歌的说法,该模型可以直接将高级指令与视觉观测映射到运动命令上。

在训练方面,谷歌结合了广泛网络规模的数据与内部机器人平台的数据(例如双臂“ALOHA 2”系统)。最终成果是一款能够应对高度动态任务的模型,即便是在训练中没有明确涵盖的情境或对象,它也能凭借庞大的底层知识库来应对。谷歌还发布了Gemini Robotics-ER,这是一种“具有高级空间理解能力的Gemini模型”,可支持机器人专家运行利用Gemini推理能力的个别程序。Gemini Robotics支持多步骤任务和精细灵巧性,它旨在成为通用机器人领域的工具——这种机器人可以处理一系列需要人类般决策能力和灵巧性的任务。此外,它还能完成复杂的多步活动,比如折叠折纸或将零食小心地装入密封袋中,这些任务不仅要求精确的手指/手部控制,还需要对材料和运动的上下文知识。

这些发展正值其他研究人员在教导手术机器人如何完成基本手术任务方面取得进展之时。Gemini Robotics遵循日常对话中的自然语言指令。Gemini Robotics有三个核心品质:通用性,即通过利用大型知识源来处理多样甚至不熟悉的指令和对象的能力;交互性,即理解和灵活响应用户命令或环境变化的能力;以及灵巧性,即以类似人类的方式操纵对象的能力。Gemini-ER本身并不处理低级控制,而是作为一个可集成到现有机器人控制器中的高级“大脑”。机器人制造商可能会将3D传感器数据输入Gemini-ER以进行高级感知和规划,然后将模型推荐的动作传递给单独的电机控制系统。这种灵活的架构旨在让任何机器人——无论是工业机械臂、人形机器人还是移动平台——都能受益于空间智能。例如,在演示中,Gemini-ER可以推断出如何通过杯子的把手握住它(以避免碰撞)并规划轨迹,它以比纯图像模型更细腻的方式“理解”环境。

随着机器人获得更多的自主性,安全性变得愈发重要。谷歌DeepMind表示,它正在采取“分层、整体的方法”来解决这个问题,这意味着它结合了传统的硬件和软件限制以防止碰撞、限制力量等。在此基础上,它增加了情境安全推理,Gemini的核心人工智能可以识别不安全指令并拒绝或提出更安全的方法。谷歌还在使用数据驱动的机器人宪法,尝试给予大型语言模型显式规则(受到阿西莫夫“三大法则”的启发)。该公司基于这一概念构建了一个动态、数据驱动的“宪法”以引导机器人行为。最后,还有ASIMOV安全基准,这是一个新的数据集/基准,用于评估机器人在不同场景中选择安全与不安全行为的频率。这旨在为具身人工智能标准化安全测试。

除了谷歌和英伟达,OpenAI已与人形机器人初创公司合作,为其配备基于GPT的“大脑”,使其能够理解人类语言并作出身体反应。微软探索使用ChatGPT自动生成无人机和机器人手臂的控制代码,而特斯拉继续致力于其Optimus人形机器人,利用其自动驾驶专业知识中的真实世界数据。还有Meta,它正在投资于像Habitat这样的模拟平台以推动具身人工智能的发展,而波士顿动力公司,以灵巧机器人闻名,正在使用更传统的控制方式,但如今正在测试基于AI的能力以实现更高自主性。

谷歌的DeepMind部门,如今也被称为谷歌DeepMind,长期以来一直是强化学习(RL)领域的先驱,这是一种广泛应用于机器人技术的基本技术。例如,DeepMind在2013年开发了深度Q网络(DQN),这是一种直接从原始像素输入和游戏分数中训练的神经网络,能够在Atari 2600游戏中达到或超过人类水平。2016年,DeepMind的AlphaGo成为首个击败世界冠军围棋选手的人工智能系统。后来的模型,如AlphaGo Zero(2017年推出),通过完全消除人类数据,展示了更大的突破。随后的发展如AlphaZero和MuZero将这些自我学习策略扩展到了国际象棋和将棋等其他复杂游戏中。DeepMind的Demis Hassabis和John Jumper也为AlphaFold等科学突破做出了重大贡献,这一成就在2024年获得了诺贝尔奖。

(以上内容均由Ai生成)