现在,您可以通过 Opera Developer 在本地使用开源 DeepSeek R1 模型

快速阅读: 据《歌剧》最新报道,最近,Opera开发者版新增了对开源DeepSeek AI模型的支持,使用户能在本地运行这些模型,无需数据离开设备。DeepSeek R1是一个开源推理模型,可通过Opera开发者版轻松安装和使用。用户只需下载最新版Opera开发者版,打开Aria界面并选择合适的DeepSeek R1模型,即可开始使用。此功能有助于提升AI模型的隐私性和响应速度。

(圣地亚哥·贝纳维德斯·加西亚 | Aria AI)

最近在Opera开发者版中启用了对开源DeepSeek AI模型的支持——去年,我们使其成为第一个内置本地LLM的网络浏览器,让您能够访问超过50个LLM家族。Opera开发者版利用Ollama框架(由llama.cpp实现),现在支持DeepSeek R1模型系列——这意味着您可以在本地运行该模型,并且没有任何数据离开您的设备。DeepSeek R1是一个开源推理模型,包括一个LLM,如果您想在设备上本地运行它,需要下载它。使用Opera开发者版,只需几步就能私密安全地在自己的机器上运行R1——让我们来看看如何操作。

在Opera开发者版中访问DeepSeek R1模型

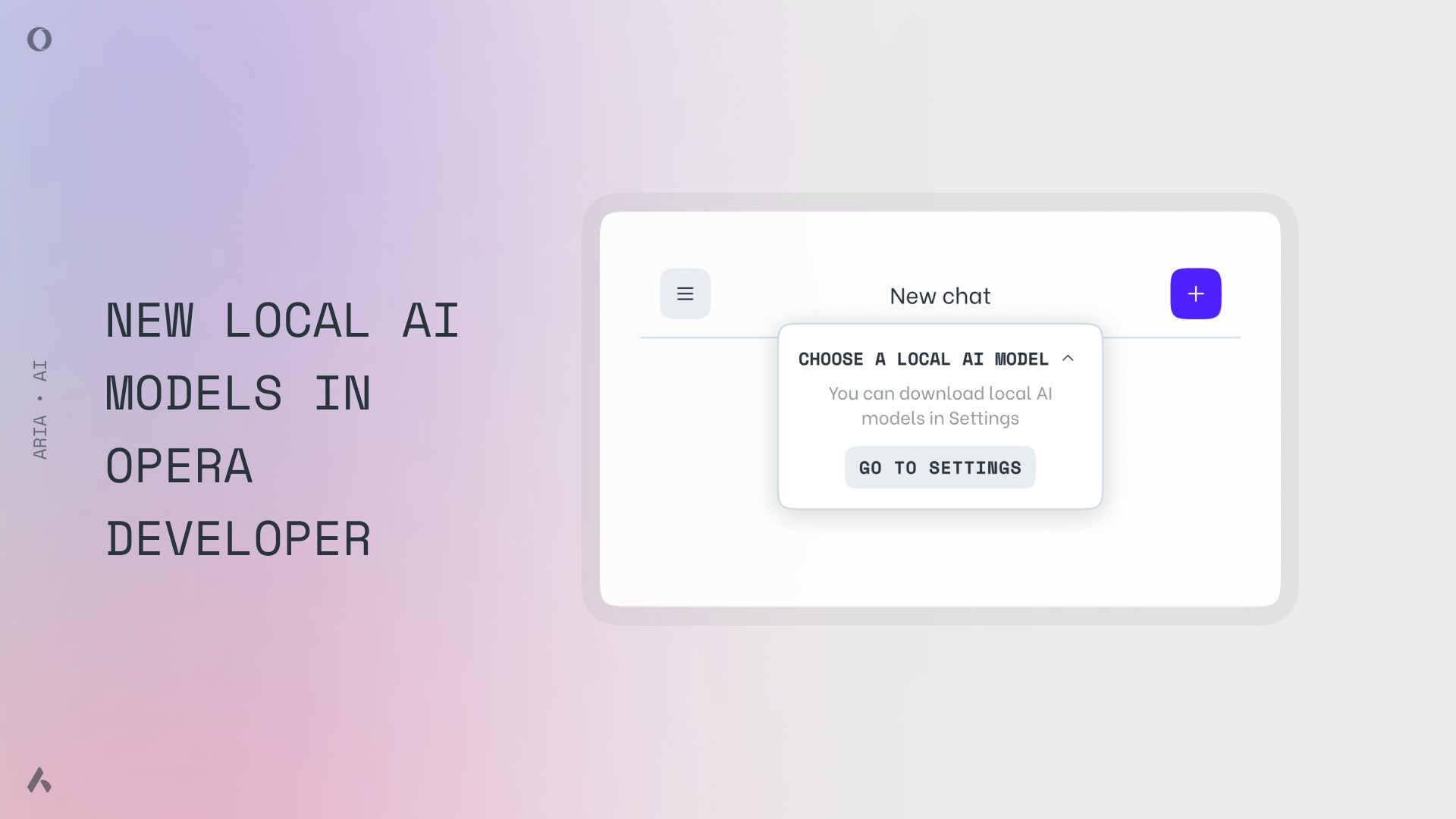

要访问各种DeepSeek R1模型,首先需要下载或更新至最新版本的Opera开发者版。一旦有了它,打开浏览器并点击左侧侧边栏中的Aria徽标。进入Aria界面后,点击左上角的这个徽标以展开聊天历史记录:

在Opera开发者版中访问DeepSeek R1模型

然后访问设置菜单——即聊天历史记录列表下的那个大按钮。进入设置菜单后,点击“本地AI模型”选项:

在搜索字段中输入“deepseek”,选择一个可用模型。点击下载按钮,就完成了!现在你只需要打开与Aria的新聊天窗口并选择你刚刚下载的模型即可。你可能已经注意到有多种DeepSeek R1模型可供选择,原因是为了让你选择计算机可以运行的一个。通常,我们建议尝试较小的模型,如deepseek-r1:14b(8.4GB)。如果你不确定计算机的本地AI能力,我们还提供了一个基准测试工具来帮你评估。

为什么推理模型很重要?

像DeepSeek R1或Open AI的o1和o3这样的推理模型在某些基准测试中表现优于普通LLM。这是因为它们是推理模型,在接收到提示后会通过多次迭代输出来验证答案质量,然后再提供给你。由于这些推理模型处理你的提示的方式,你可以预期回答时间会显著增加——至少与我们现在所说的“正常LLM”的回答时间相比。DeepSeek R1的一个有趣之处在于你可以看到它执行以得出答案的思想过程或想法链——就好像它在自言自语一样。而Open AI的o1和o3仅对付费客户开放,DeepSeek R1是公开可用的(开放式权重模型),这就是Opera现在可以通过Opera开发者版浏览器提供一个您可以下载和本地运行的真实推理模型的原因。如今,你可以在机器上运行相当强大的模型。但我们认为,访问这些模型不应局限于最精通技术的人,这就是我们确保你可以轻松下载和试用它们的原因。

测试推理模型的能力

如果你想测试DeepSeek R1或其他推理模型的推理能力,可以问草莓这个词中有多少个“R”——真的,它现在能答对。严肃地说,你可以使用一个数学奥林匹克问题作为测试,因为这对模型来说应该是个公平的考验。让我们试试这个:边长为20的正方形内是否存在一点,其到正方形四边的距离为四个连续整数?此时,DeepSeek展示了它的“推理”过程——它的思想过程——从而解决了这个问题:

这个问题的答案确实是在正方形内不存在这样的点。试图用普通的LLM——例如GPT 4o——回答这个问题会得到不一致的结果,有时可能是正确的但大多数时候是错误的。然而,像DeepSeek R1、o1或o3这样的推理模型可以解决这个问题。与推理模型交互时,需要注意它们需要更长时间来处理查询并生成答案。根据你的硬件和使用的模型复杂度,它可能需要几分钟才能开始显示任何内容。

使用Opera开发者版尝试DeepSeek R1

今天就下载Opera开发者版来体验DeepSeek R1,并记得使用devicetest.ai测试你的机器以评估本地AI性能。使用Opera开发者版尝试DeepSeek R1

圣地亚哥·贝纳维德斯·加西亚

Aria AI

Opera开发者版

(以上内容均由Ai生成)