阿里推Qwen3全模态大模型,支持119种语言实时交互

快速阅读: 12月11日消息,阿里巴巴Qwen团队发布Qwen3-Omni-Flash全模态大模型,支持多模态实时交互与高自然度语音生成,已上线API并计划2025年推出轻量版及语音克隆、视频驱动头像功能。

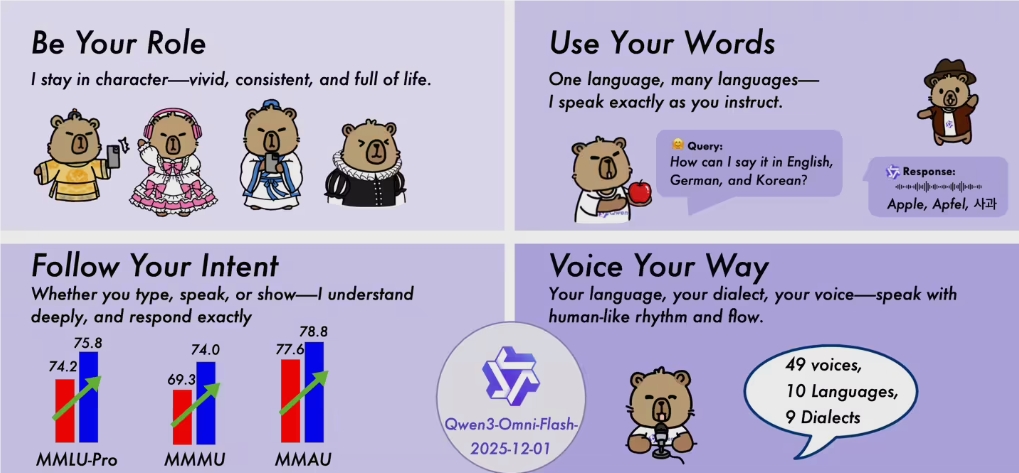

阿里巴巴Qwen团队日前发布新一代全模态大模型Qwen3-Omni-Flash-2025-12-01。该模型支持文本、图像、音频和视频的无缝输入,并通过实时流式架构同步生成高质量文本与自然语音,其语音自然度已接近真人水平。

新模型可实现多模态内容的实时交互,支持119种文本语言、19种语音识别语言及10种语音合成语言,有效提升跨语言场景下的响应准确性。此外,系统全面开放System Prompt自定义权限,用户可根据需求设定特定人设风格、调整口语化程度及回复长度,模型还能依据内容自适应调节语速、停顿与韵律,增强个性化体验。

在性能方面,Qwen3-Omni-Flash在多项基准测试中显著提升:逻辑推理任务(ZebraLogic)得分提高5.6,代码生成(LiveCodeBench-v6)提升9.3,多学科视觉问答(MMMU)提升4.7,展现出更强的多模态理解与分析能力。

目前,该模型已通过API上线,输入定价为1元/百万tokens,输出为3元/百万tokens,并集成于Qwen Chat提供Demo服务,支持上传30秒视频并实时生成带画面口播。此举将大幅降低直播、短视频及虚拟会议等场景中对配音与后期制作的成本。

据悉,团队计划于2025年第一季度推出70B轻量版,可在单张A100显卡上运行实时流;第二季度开放“语音克隆10秒”接口;第三季度上线“视频驱动头像”Beta功能。

(以上内容均由Ai生成)