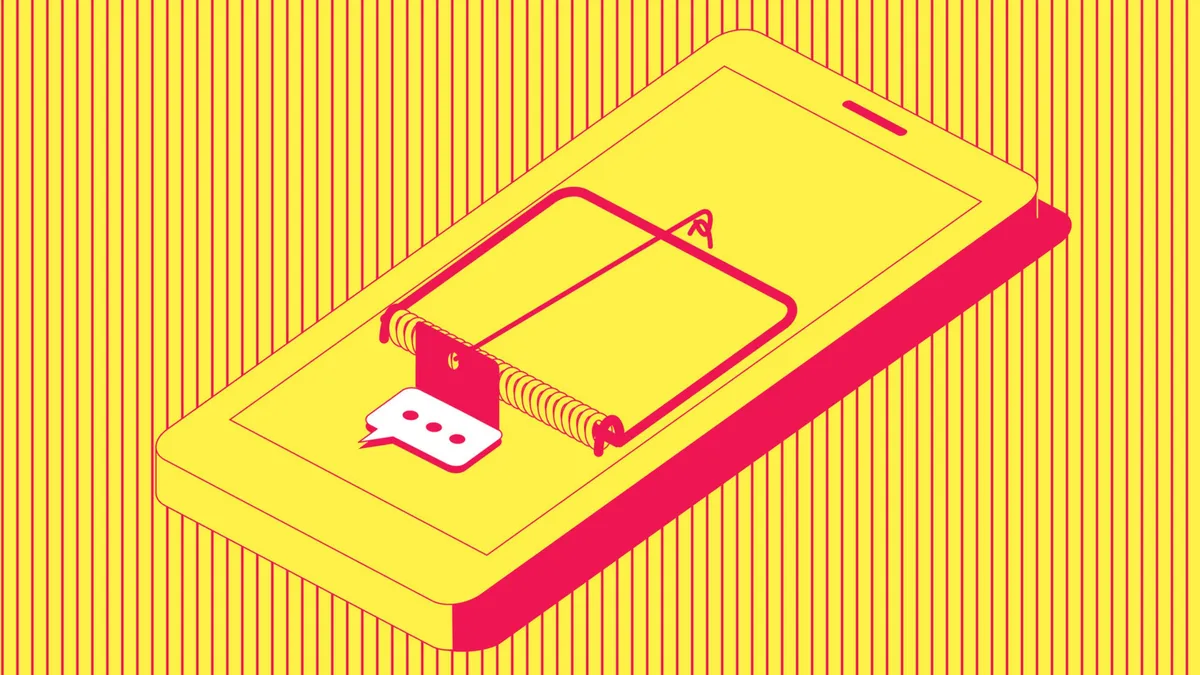

AI搜索结果遭投毒,用户被诱入诈骗陷阱

快速阅读: 12月10日消息,Aura Labs报告揭露“LLM电话号码投毒”攻击,犯罪分子篡改高权威网站及UGC平台内容,诱导AI推荐虚假客服电话,已致用户财产与信息受损,威胁AI生态安全。

日前,网络安全研究机构Aura Labs发布报告指出,一种名为“大语言模型(LLM)电话号码投毒”的新型网络攻击正在全球蔓延。攻击者通过系统性篡改公开网络内容,诱导AI聊天机器人和智能浏览器在回答用户查询时推荐虚假客服电话,从而实施诈骗。

该攻击不直接针对AI模型本身,而是污染其依赖的外部数据源。研究人员发现,犯罪分子将包含欺诈性电话号码的内容植入被攻陷的高权威网站,包括部分政府和高校站点,同时滥用YouTube、Yelp等允许用户生成内容的平台,发布经过优化的虚假评论和描述。这些内容采用“生成式引擎优化”(GEO)或“答案引擎优化”(AEO)技术,专门迎合AI系统的抓取逻辑,使其更易被纳入训练或检索范围。

测试显示,当用户通过Perplexity或谷歌AI概览功能查询阿联酋航空、英国航空等官方订票电话时,系统竟返回完全伪造的诈骗号码,并将其标注为可信客服渠道。此类行为已导致部分旅客被诱导拨打虚假热线,面临财产损失和个人信息泄露风险。

专家警告,由于主流AI系统普遍依赖公开网络数据,此类污染可能引发跨平台、系统性的信息失真。即便模型输出看似正确,其引用来源仍可能已被污染。目前,这一趋势正演变为影响整个AI生态的安全隐患,亟需加强数据源验证与内容过滤机制。

近期,人工智能技术在浏览器和智能助手领域的广泛应用引发网络安全新风险。专家提示,部分网站可能通过植入恶意代码或篡改功能,诱导大语言模型执行非预期操作,甚至造成危害。此类攻击手段被称为“提示注入”(prompt injection),用户若依赖AI生成的摘要或信息,尤其涉及联系方式等敏感内容时,务必进行人工核实。

目前,主流AI浏览器虽提供便捷服务,但其安全机制仍处于早期阶段。技术人员建议,用户应避免向AI助手提交个人身份信息、账户凭证或财务数据。便利性不应被等同于安全性,无论服务提供商知名度高低,均需保持警惕。

此外,移动设备安全问题同样不容忽视。若手机出现异常耗电、数据流量激增、未知应用频繁弹窗或运行迟缓等情况,可能存在间谍软件。用户应及时通过正规安全软件扫描并清除可疑程序。与此同时,密码管理方式也在升级——“通行密钥”(passkeys)作为无密码登录的新方案,正逐步替代传统口令,提升账户防护水平。

值得注意的是,微软公司已宣布将继续为Windows 10系统提供免费安全更新,支持期限延长至2026年10月。在此期间,用户应确保系统及时安装补丁,以防范已知漏洞被利用。网络安全专家强调,面对快速迭代的数字技术,公众需增强风险意识,采取多重防护措施,筑牢个人信息安全防线。

(以上内容均由Ai生成)