商汤发布NEO架构,原生多模态模型数据需求减90%仍达SOTA

快速阅读: 商汤科技与南洋理工大学S-Lab联合发布原生多模态架构NEO,开源2B和9B两版模型。NEO革新了视觉编码和位置编码技术,实现“像素到Token”连续映射,显著降低数据需求,提升多模态模型性能。

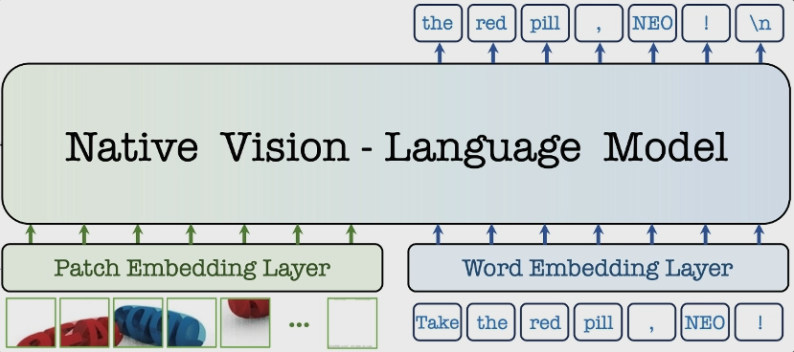

商汤科技与南洋理工大学S-Lab合作发布了行业首个原生多模态架构NEO,并开源了2B和9B两个版本的模型。该架构摒弃了传统的“视觉编码器+投影器+语言模型”三段式方案,从注意力机制、位置编码到语义映射均进行了全面重写。官方表示,在相同性能下,NEO的数据需求仅为行业平均水平的十分之一,首次实现了“像素到Token”的连续映射。

据商汤的技术负责人介绍,NEO通过原生图块嵌入层直接读取像素,取消了独立的图像Tokenizer;采用三维旋转位置编码(Native-RoPE)在同一个向量空间内同时表达文本和视觉时空频率;多头注意力机制采用“视觉双向+文本自回归”的混合计算方式,提升了空间结构关联得分24%。测试结果显示,在参数范围从0.6B到8B之间,NEO在ImageNet、COCO及Kinetics-400等多个基准上达到了最先进水平,且在边缘设备上的推理延迟低于80毫秒。

目前,NEO的模型权重和训练脚本已在GitHub上公开,商汤计划于明年第一季度进一步开源3D感知与视频理解版本。业内专家认为,NEO的“深层融合”方法有望终结多模态领域的“拼积木”模式,为终端小模型提供新的性能标准。

(以上内容均由Ai生成)