AWS推出Bedrock新功能,简化GPT-OSS模型部署

快速阅读: AWS推出Amazon Bedrock Custom Model Import,支持GPT-OSS模型轻松部署,涵盖20亿和120亿参数变体,助力企业迁移至AWS,提升应用开发效率。

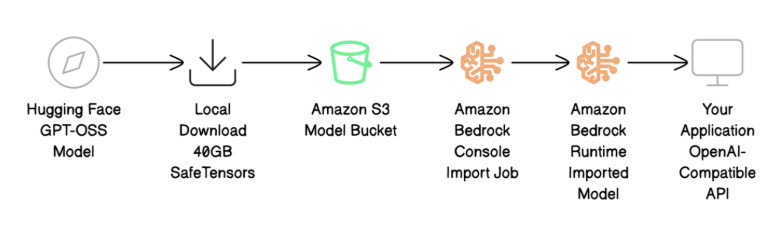

近日,亚马逊网络服务(AWS)推出了一项新功能——Amazon Bedrock Custom Model Import,使用户能够轻松部署开源的GPT-OSS模型。这项新功能支持20亿和120亿参数的GPT-OSS变体,帮助企业保留API兼容性的同时,将现有应用程序迁移至AWS平台。使用该功能,用户只需将模型文件上传至Amazon S3,通过Amazon Bedrock控制台启动导入,AWS将自动完成GPU配置、推理服务器搭建及按需自动扩展,让用户专注于应用开发。

GPT-OSS模型由OpenAI推出,是首批开源的语言模型之一,广泛应用于推理和工具使用等领域。用户可根据需求选择合适的模型,其中GPT-OSS-20B适用于对速度和效率有高要求的场景,而GPT-OSS-120B则更适合复杂的推理任务。这两款模型均采用了专家混合架构,仅在请求时激活最相关的模型组件,确保了高效性能。

部署过程分为四个主要步骤:下载并准备模型文件、将文件上传至Amazon S3、使用Amazon Bedrock进行模型导入以及通过OpenAI兼容的API调用测试模型。用户需要拥有AWS账号及适当权限,并在目标区域创建S3存储桶。完成模型导入后,用户可以通过熟悉的OpenAI聊天完成API格式进行测试,确保模型正常运行。此外,迁移到AWS的过程几乎不需要更改代码,只需调整调用方式,消息结构保持不变。

在使用新功能时,AWS建议用户遵循最佳实践,如文件验证和安全设置,以确保模型部署的顺利进行。AWS还将继续扩大Bedrock服务的区域覆盖,以满足更多用户的需求。

(以上内容均由Ai生成)