东北大学开源多语言翻译模型,覆盖60语种234方向

快速阅读: 东北大学“小牛翻译”团队开源NiuTrans.LMT,覆盖60种语言、234个翻译方向,采用中-英双中心架构,打破英语霸权,实现低资源语言翻译突破,推动语言平等与跨文化交流。

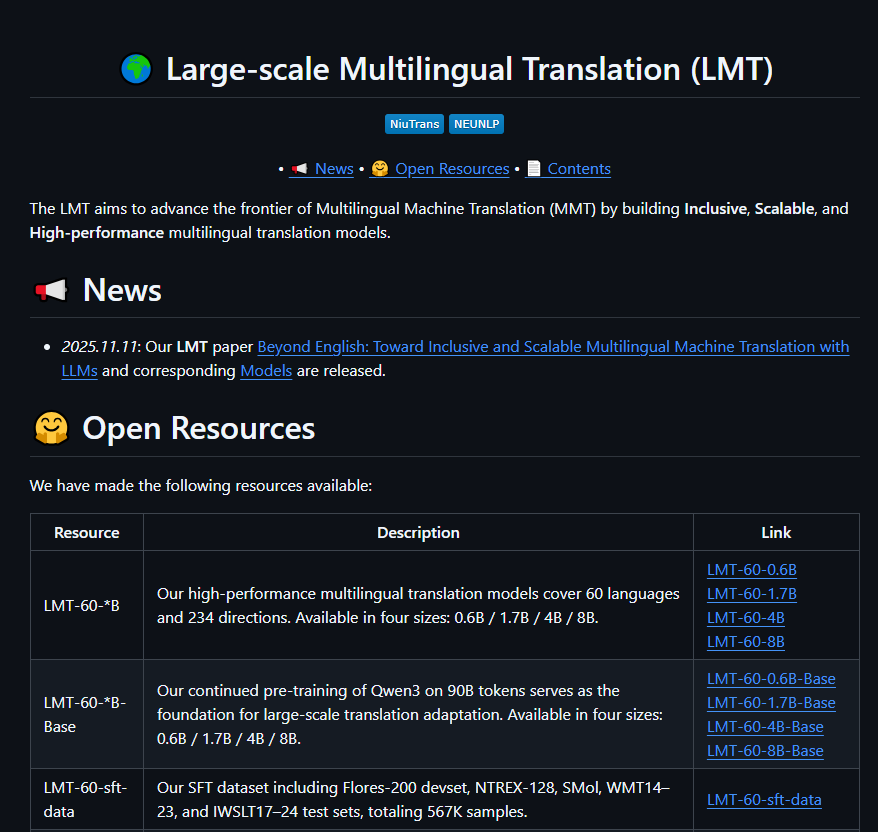

中国AI翻译技术再攀高峰。近日,东北大学“小牛翻译”团队正式开源其最新大模型——NiuTrans.LMT(Large-scale Multilingual Translation),实现60种语言、234个翻译方向的全面覆盖。该模型不仅以中文和英文为核心构建全球语言桥梁,还在藏语、阿姆哈拉语等29种低资源语言上取得显著突破,为全球语言平等迈出关键一步。

双中心架构,打破“英语霸权”。不同于多数以英语为唯一枢纽的翻译模型,NiuTrans.LMT采用中-英双中心设计,支持中文与58种语言、英文与59种语言的高质量直译,避免了“中文→英文→小语种”的二次失真。这一架构尤其有利于“一带一路”沿线国家与中文使用者的直接沟通,推动跨文化交互去中介化。

三层语言覆盖,兼顾效率与公平。模型精准划分语言资源层级:13种高资源语言(如法语、阿拉伯语、西班牙语)翻译流畅度媲美人类;18种中资源语言(如印地语、芬兰语)在专业术语与语法结构上高度准确;29种低资源语言(含藏语、斯瓦希里语、孟加拉语等)通过数据增强与迁移学习,实现了从“不可译”到“可用译”的跨越。

两阶段训练,性能登顶FLORES-200。NiuTrans.LMT在权威多语言基准FLORES-200上表现卓越,稳居开源模型榜首。其成功源于创新的两阶段训练流程:继续预训练(CPT)在900亿tokens的多语言语料上均衡学习,确保小语种不被淹没;监督微调(SFT)整合FLORES-200、WMT等高质量平行语料(56.7万条样本,覆盖117方向),精调翻译准确性与风格一致性。

四大规模开源,从科研到商用全覆盖。为满足不同场景需求,团队同步开源0.6B、1.7B、4B、8B四种参数规模模型,全部可在GitHub与Hugging Face免费下载。轻量版可在消费级GPU运行,适合移动端部署;8B版本则面向企业级高精度翻译场景,支持API集成与私有化部署。

AIbase认为,NiuTrans.LMT的发布不仅是一项技术成果,更是对“语言多样性保护”的实际行动。当AI能够精准翻译藏语诗歌、非洲谚语或北欧古语时,技术才真正具备人文温度。东北大学这一开源举措,正为全球构建一个无语言壁垒的数字未来奠定基石。

项目地址:https://github.com/NiuTrans/LMT

(以上内容均由Ai生成)