IBM发布Granite4.0Nano模型,提升小型AI性能

快速阅读: IBM推出四款Granite4.0Nano模型,参数规模350万至15亿,可在普通硬件上运行,支持Apache 2.0许可,兼容多种工具,性能优越,促进AI普及。

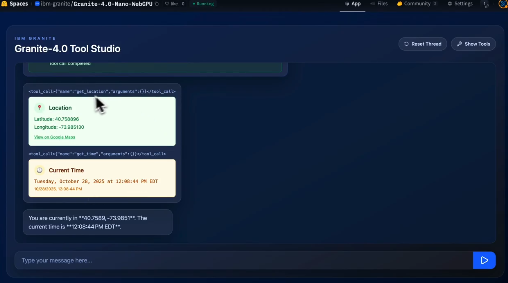

近日,IBM 推出了四款新的 Granite4.0Nano 模型,这些模型的参数规模从350万到15亿不等,体现了公司在人工智能领域对高效与普及性的重视。不同于行业内的大型模型多依赖云计算的趋势,Granite4.0Nano 模型能够在普通笔记本电脑上运行,甚至在浏览器中本地运行。这使得开发者无需依赖云服务,就能在消费者硬件或边缘设备上构建应用。

所有 Granite4.0Nano 模型均在 Apache 2.0 许可下发布,适用于研究人员、企业和独立开发者,并支持商业用途。这些模型与多种工具兼容,如 llama.cpp、vLLM 和 MLX,且已获得 ISO 42001 负责任AI开发认证。

Granite4.0Nano 家族包括四款模型:Granite-4.0-H-1B(约1.5亿参数)、Granite-4.0-H-350M(约350万参数)、Granite-4.0-1B(接近2亿参数的变种)和 Granite-4.0-350M(变种)。H 系列模型采用混合状态空间架构,适合低延迟的边缘环境,而标准变压器模型则提供更广泛的兼容性。

尽管市场上已存在多种小型语言模型,但 IBM 的 Nano 家族凭借其卓越性能脱颖而出。最新的基准测试表明,Granite4.0 模型在多个领域表现优于同类产品。IBM 的研究团队指出,这些模型在指令跟随和功能调用任务中表现出色,并且在内存需求和运行速度方面具有优势,能够在移动设备或 CPU 上流畅运行。

值得一提的是,IBM 不仅发布了这些模型,还积极参与开发者社区的互动,收集反馈并讨论未来的开发方向。Granite 团队在 Reddit 平台上与用户交流,展现了公司推动开源AI发展的努力。

链接:https://huggingface.co/blog/ibm-granite/granite-4-nano

要点:

– IBM 发布了 Granite4.0Nano 模型,支持在普通硬件上运行,提高了小型 AI 模型的可用性。

– 所有模型均在 Apache 2.0 许可下发布,适用于研究和商业用途,确保了开放性和兼容性。

– 最新基准测试显示,Granite4.0 模型在性能上超越同类产品,展现出高效的处理能力。

(以上内容均由Ai生成)