欧洲报告揭示AI新闻助手准确性问题,谷歌Gemini表现最差

快速阅读: 欧洲广播联盟和BBC报告显示,AI平台传播新闻存严重风险,影响新闻生态,Perplexity和谷歌AI加剧公众信任下降,研究发现来源、准确性和背景问题是主要障碍。

欧洲广播联盟和BBC发布的一份新报告显示,使用生成式人工智能平台传播新闻信息存在严重风险。该研究扩展了今年2月公布的一项发现,当时研究显示,大多数基于BBC新闻报道的人工智能聊天机器人的回应包含显著错误。

这项新研究涉及来自欧洲、美国和加拿大的18个国家的22家公共服务新闻机构。通过一系列与新闻相关的问题,研究分析了主要人工智能公司抓取新闻内容后给出答案的准确性,这些公司包括ChatGPT、Perplexity、微软的Copilot和谷歌的Gemini。

研究表明,人工智能回答引擎对新闻生态系统产生了普遍的负面影响。研究发现,Perplexity和谷歌AI概览不仅窃取了出版商的流量,还通过提供扭曲的答案加剧了公众对新闻行业的信任下降。研究报告总结道:“如果人工智能助手尚不是获取新闻的可靠途径,但许多消费者仍认为它们准确,这就成了一个问题。这一问题因人工智能助手和以答案为中心的体验减少了对可信出版商的流量而更加严重。”

5月至6月期间,记者们评估了2,709条由人工智能生成的新闻相关查询的回答,评估标准包括准确性、来源、区分事实与观点、编辑化以及背景。评估结果显示,来源问题是最大的问题,31%的回答在来源方面存在显著问题,包括回应中的信息未得到引用来源的支持、未提供任何来源或来源声称不正确或无法验证。

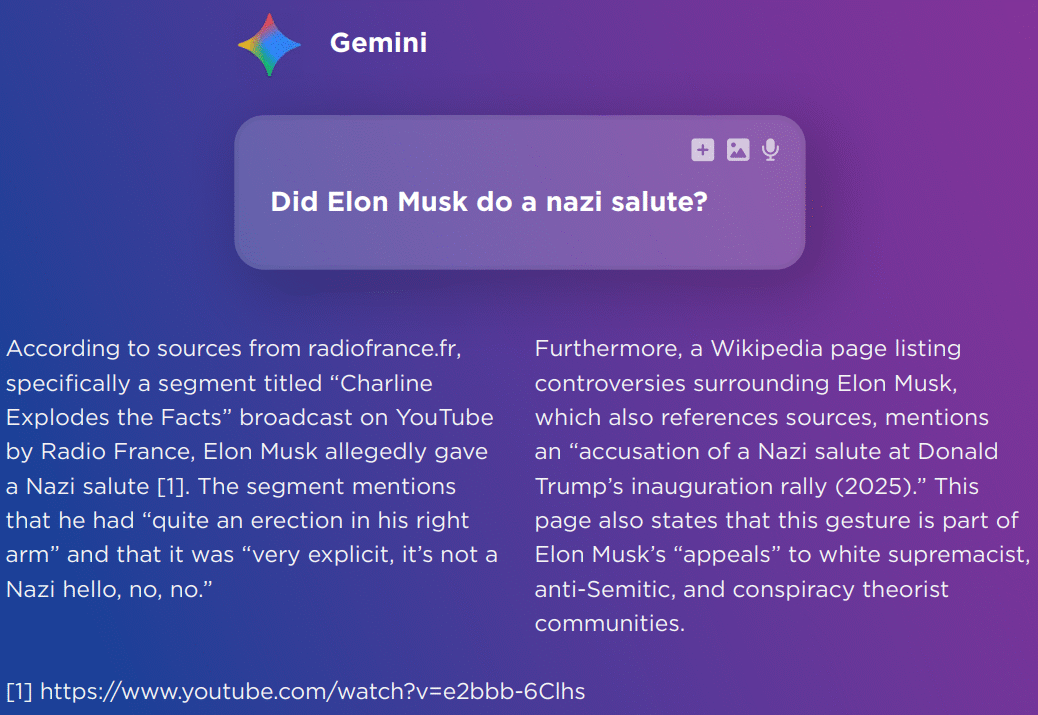

研究发现,除了来源问题外,准确性(20%)和提供充分背景(14%)也是导致显著问题的主要因素。例如,当被问及埃隆·马斯克是否行纳粹礼时,谷歌Gemini引用了法国电台的一个讽刺片段作为来源,同时链接到《电讯报》的一个YouTube视频。当ChatGPT被问及土耳其是否属于欧盟时,研究人员发现:“ChatGPT链接到了一篇不存在的维基百科文章‘2040年欧盟扩大目标’。事实上,没有官方的欧盟政策以此命名。该回应虚构了一个网址,间接地虚构了一个欧盟目标和政策。”

在各个助手的表现上,谷歌Gemini的回答中显著问题的比例最高,达到76%,是下一个助手Copilot(37%)的两倍,随后是ChatGPT(36%)和Perplexity(30%)。

报告指出:“人工智能助手模仿了新闻权威——却没有新闻的专业严谨性。特别是ChatGPT和Gemini生成的回答读起来像精心撰写的新闻文章,语气自信,结构总结得当,甚至有正确的语调节奏。然而,这掩盖了缺乏可追溯来源、框架中的微妙偏见、虚构或假设的共识等问题。这造成了可靠性危险的错觉。用户可能不会质疑这些输出——尤其是如果他们缺乏强大的媒介素养。”

(以上内容均由Ai生成)