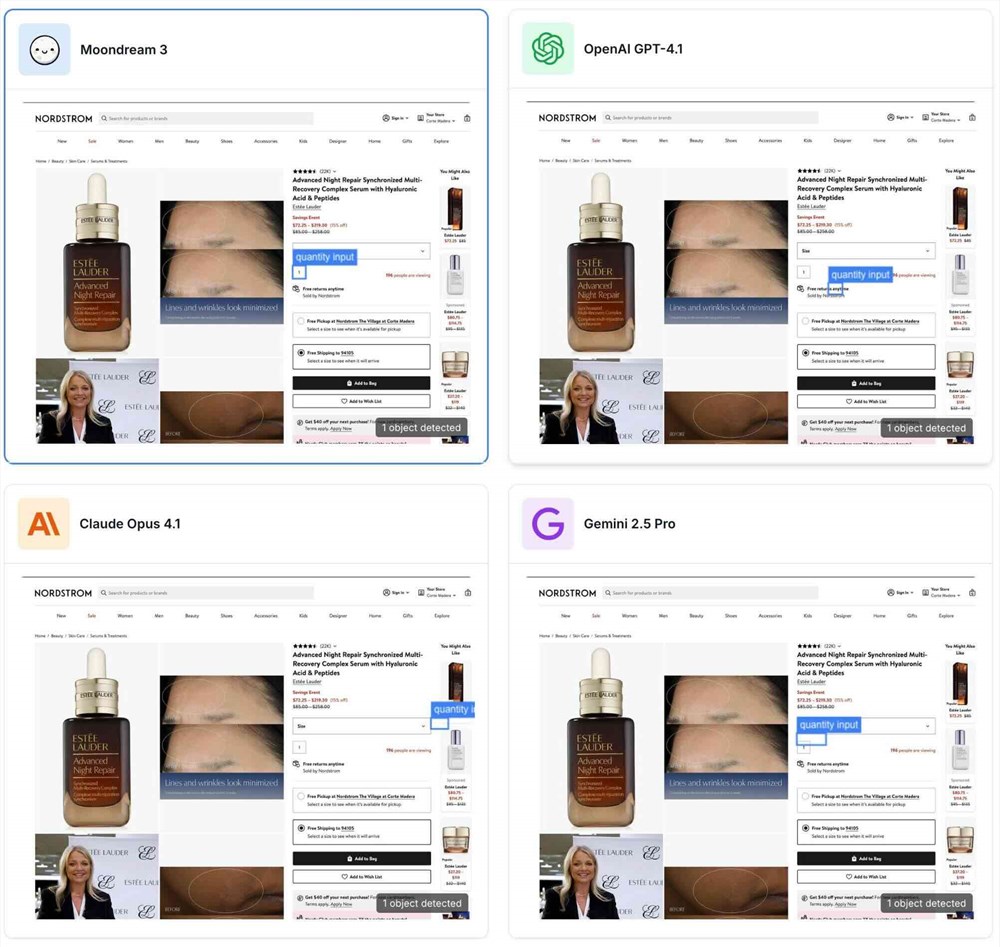

Moondream 3.0轻量模型超越GPT-5,引领VLM新潮流

快速阅读: Moondream3.0发布,采用高效MoE架构,总参数9亿激活2亿,实现前沿视觉推理,超越GPT-5等模型。支持32K上下文,适用于实时交互。具备全能视觉技能,如物体检测、计数、字幕生成等,广泛应用于安防、医疗等领域。

在视觉语言模型(VLM)领域,一场“小而美”的革命正在上演。最近发布的Moondream3.0(预览版)以高效的混合专家(MoE)架构,通过总参数9亿、激活参数仅2亿的轻量设计,实现了前沿的视觉推理能力。这款升级版模型不仅在复杂场景中表现出色,在多项基准测试中甚至超过了GPT-5、Gemini和Claude4等领先模型,引起了AI社区的广泛关注。与今年1月至2月推出的擅长验证码识别的Moondream2版本相比,3.0版本拓展了应用范围,支持32K上下文长度,适合实时交互和代理工作流。

核心架构方面,Moondream3.0采用了创新的MoE架构,虽然总参数达到9亿,但激活参数仅为2亿,保证了与前代相当的推理速度,同时具备高效部署的特点。模型集成了SigLIP视觉编码器,支持多裁剪通道拼接,实现了高效的高分辨率图像处理。其隐藏维度为2048,使用自定义的高效SuperBPE分词器,并引入了多头注意力机制,结合位置和数据依赖的温度缩放,增强了长上下文的建模能力。这种设计源自Moondream2的“上采样”初始化,训练数据约为450亿令牌,远少于头部模型的万亿级规模,但依然实现了无妥协的性能表现。开发者可以通过Hugging Face轻松下载该模型,支持云API和本地运行,目前需要24GB以上的NVIDIA GPU内存,未来将推出量化版和Apple Silicon支持。

能力升级方面,Moondream3.0的最大亮点在于其“全能”的视觉技能,涵盖开放词汇物体检测、点选、计数、字幕生成和OCR。模型支持结构化输出,例如可以直接生成包含狗ID、毛色、背带颜色的JSON数组,并在UI理解、文档转录和物体定位等方面表现出色。早期基准测试显示,该模型在COCO物体检测中的得分达到51.2(比前代提高了20.7),在OCRBench上的成绩从58.3提升到61.2,ScreenSpot UI F1@0.5达到了60.3。

实际演示中,该模型能够轻松应对复杂场景,如识别穿着紫色袜子的人、选中购物网页的数量输入框、标记瓶子、推荐最适合意大利面的餐具,甚至处理动态跟踪和问题解答。这些能力不仅适用于安防监控、无人机巡检,还扩展到了医学影像和企业级文档处理,推理速度是大型模型的数倍,运行成本大幅降低。

应用潜力方面,Moondream3.0作为开源模型,强调“无需训练、无需地面真相数据、无需重型基础设施”的理念,开发者只需简单的提示就能解锁视觉理解功能。社区反馈表明,该模型已经在机器人语义行为、移动设备和Raspberry Pi上成功部署,适用于边缘计算场景。相比于国内领先的开放权重VLM(如Qwen系列),Moondream3.0在视觉推理和结构化输出上具有明显优势,不过详细的跨国评测仍在进行中。未来,该模型将继续迭代,优化推理代码并提高基准分数。

(以上内容均由Ai生成)