小米开源语音大模型 Xiaomi-MiMo-Audio,实现少样本泛化

快速阅读: 小米9月19日宣布开源Xiaomi-MiMo-Audio,首现语音领域少样本泛化能力,超越Google和OpenAI模型,推动语音AI发展。

9月19日,小米公司宣布开源其首个原生端到端语音大模型 Xiaomi-MiMo-Audio,这一成果标志着语音技术领域的重要突破。五年前,GPT-3的问世开启了语言通用人工智能(AGI)的新纪元,然而,语音领域因依赖大规模标注数据,难以实现类似的少样本泛化能力。如今,小米推出的 Xiaomi-MiMo-Audio 模型基于创新的预训练架构和上亿小时的训练数据,首次在语音领域实现了基于上下文学习(ICL)的少样本泛化,并在预训练过程中观察到了显著的“涌现”现象。

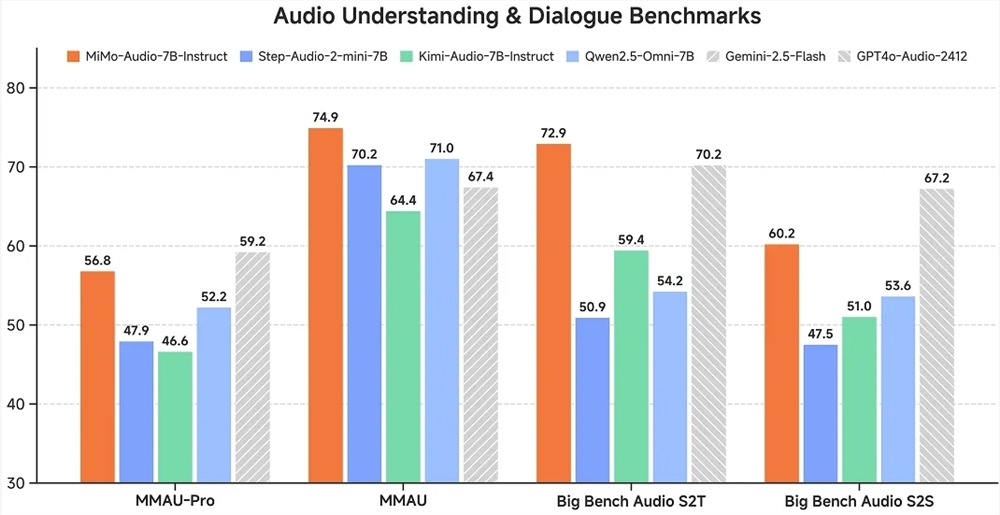

Xiaomi-MiMo-Audio 模型在多个标准评测基准中表现出色,不仅超越了同参数量的开源模型,还在音频理解基准 MMAU 的标准测试集上超过了 Google 的闭源语音模型 Gemini-2.5-Flash,并在音频复杂推理基准 Big Bench Audio S2T 任务中超越了 OpenAI 的闭源语音模型 GPT-4o-Audio-Preview。这一成就不仅彰显了小米在语音技术领域的深厚实力,也为语音 AI 的发展指明了新方向。

小米此次开源的 Xiaomi-MiMo-Audio 模型有多项创新。首先,该模型首次证明了将语音无损压缩预训练扩展至1亿小时可以“涌现”出跨任务的泛化性,表现为少样本学习能力,被视为语音领域的“GPT-3时刻”。其次,小米是首个明确语音生成式预训练目标和定义的公司,并开源了一套完整的语音预训练方案,包括无损压缩的 Tokenizer、全新模型结构、训练方法和评测体系,开启了语音领域的“LLaMA时刻”。此外,Xiaomi-MiMo-Audio 是首个将思考过程同时引入语音理解和语音生成过程中的开源模型,支持混合思考。

小米采取了简单、彻底和直接的开源策略,旨在加速语音研究领域的发展。开源内容包括预训练模型 MiMo-Audio-7B-Base 和指令微调模型 MiMo-Audio-7B-Instruct,以及 Tokenizer 模型、技术报告和评估框架。MiMo-Audio-7B-Instruct 模型可通过提示切换 non-thinking 和 thinking 两种模式,具备较高的强化学习起点和潜力,可作为研究语音 RL 和代理训练的新型基座模型。Tokenizer 模型具有1.2B参数量,采用 Transformer 架构,兼顾效率与性能,从零开始训练,覆盖超过千万小时的语音数据,同时支持音频重建和音频转文本任务。技术报告详细介绍了模型和训练细节,评估框架支持10多个测评任务,现已开源至 GitHub。

小米公司表示,Xiaomi-MiMo-Audio 的开源将显著推动语音大模型研究向语言大模型靠拢,为语音 AGI 的发展奠定重要基础。小米将继续开源,期待与每一位同行者共同合作,通过开放与协作,迈向语音 AI 的“奇点”,迎接未来的人机交互时代。

(以上内容均由Ai生成)