Meta 推出小型AI模型,企业应用迎来新变革

快速阅读: Meta推出MobileLLM-R1小型推理模型,涵盖140M至950M参数,优化数学、编码和科学推理,适用于资源有限设备。模型在编码测试中表现优异,但仅限非商业用途。此发展标志着企业AI应用向小型化、高效率转变的趋势。

近期,Meta公司推出了一款名为MobileLLM-R1的小型推理模型,引起了业界对“小型AI”在企业应用中的广泛关注。过去,人工智能模型的强大能力通常与其庞大的参数规模相关联,许多模型的参数量达到了数百亿甚至数万亿。

然而,超大规模模型在企业应用中面临诸多挑战,如对底层系统的控制不足、依赖第三方云服务及成本难以预测等问题。为此,小型语言模型(SLMs)的发展势头日益增强,旨在满足企业在成本、隐私和控制方面的需求。

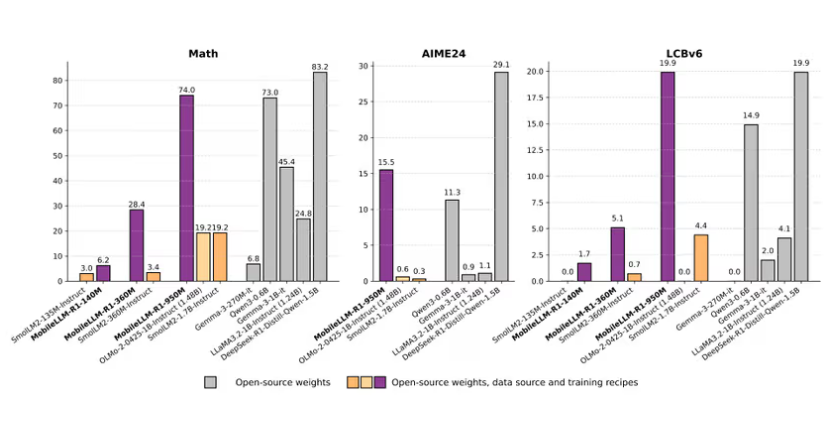

MobileLLM-R1系列模型包括140M、360M和950M三种参数规模,专为数学、编码和科学推理进行了优化。这些模型采用了“深而薄”的架构设计,通过优化的训练过程,使其能够在资源有限的设备上执行复杂的任务。此外,MobileLLM-R1在MATH基准测试中的表现略优于阿里巴巴的Qwen3-0.6B,特别是在LiveCodeBench编码测试中表现突出,适合在开发工具中提供本地代码辅助。

需要注意的是,MobileLLM-R1目前仅在Meta的FAIR非商业许可下发布,禁止任何商业用途,更适合用作研究蓝图或内部工具,而不是直接用于商业化的成品。

在小型语言模型的竞争领域,Google的Gemma3(270M参数)以超高效的性能著称,其许可证更为宽松,适合企业定制使用。同时,阿里巴巴的Qwen3-0.6B也是一个不错的选择,提供了无限制的商业使用。Nvidia的Nemotron-Nano则在控制功能上独具优势,支持开发者根据需求调整推理过程。

随着企业逐步认识到小型模型带来的可控性和经济性,行业正经历向小型专用模型的转型。许多企业发现,小型模型能提供更高的可预测性和隐私保护。此外,利用一系列小型专用模型解决复杂问题的策略,与软件行业向微服务架构的转变相类似。

这一变革并不意味着大型模型将被取代,相反,它们将继续发挥重要作用,通过优化训练数据,为新一代小型模型提供理想的训练集。这一趋势表明,未来的AI发展将更加可持续,各大公司正朝着更加务实的AI未来迈进。

(以上内容均由Ai生成)