谷歌调整数据让AI看起来不那么耗资源

快速阅读: 谷歌发布报告称,Gemini应用生成中等长度文本提示时,耗电0.24瓦时,用水0.26毫升,远低于此前估计。但加州大学河滨分校教授Ren Shaolei认为,谷歌将现场用水量与总用水量混淆,存在误导。

谷歌发布最新报告显示,软件进步显著降低了Gemini的用水量,每条提示仅需约五滴水,远低于此前估计。谷歌采用新的测试方法,估计其Gemini应用生成中等长度文本提示时,耗电0.24瓦时,用水0.26毫升。

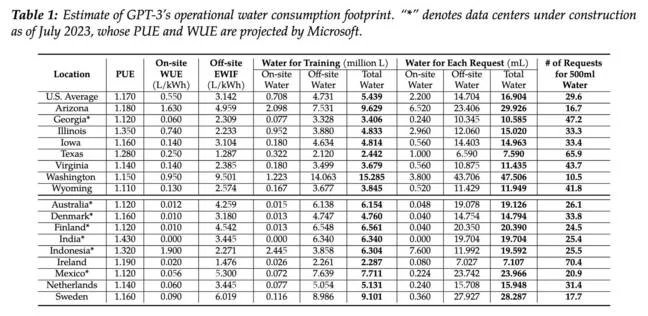

谷歌指出,这远远少于Mistral AI和加州大学河滨分校研究人员估计的45至47.5毫升,后者是使用中等规模模型(如Mistral Large 2或GPT-3)生成大约一页文本所需的水量。然而,加州大学河滨分校电气与计算机工程副教授Ren Shaolei认为,谷歌的说法具有误导性,因为它将现场用水量与总用水量混淆。

了解这一点很重要,因为数据中心不仅在现场消耗水资源,还通过能源生产间接消耗大量水资源。这些设施通常使用冷却塔,蒸发泵入的水以冷却进入的数据中心空气,防止CPU和GPU过热。据谷歌估计,其数据中心附近约80%的水资源用于蒸发冷却。

此外,发电厂同样需要冷却塔,这些塔也消耗大量水资源。因此,即使数据中心本身不直接消耗水资源,它们仍可能对当地水资源产生重大影响。Ren强调,问题不在于谷歌完全忽略了场外用水量,而是谷歌将现场用水量与包含所有用水量的数据进行比较。

“如果你想关注现场用水量,那没问题,但你也需要将你的现场数据与之前研究的现场数据进行比较。”谷歌没有这样做。而加州大学河滨分校的研究也包括了现场用水量的估算。谷歌本可以进行同类比较,但选择了不这样做,Ren表示:“他们的做法不符合我们对任何论文,尤其是谷歌论文的最低期望。”

加州大学河滨分校2023年的论文《让AI不再“口渴”:揭示并解决AI模型的秘密水资源足迹》估计,美国平均数据中心每次请求的现场用水量为2.2毫升。从该论文可以看出,现场用水量远低于谷歌报告中提到的每条提示50毫升。

谷歌声称的每条提示0.26毫升用水量仍远低于加州大学河滨分校估计的美国数据中心现场平均用水量2.2毫升。Ren指出,这些数据是在2023年首次发布的。如果谷歌确实在过去一年内将Gemini的能耗减少了33倍,那么在Ren团队发布结果时,该模型的水效可能更低。

Ren认为,随着时间推移,AI工作负载变得更加高效并不令人意外。在原始论文中,他的团队已经预测到水和能源消耗会有所改善。

(以上内容均由Ai生成)