GEPA优化大模型,无需昂贵强化学习

快速阅读: 加州大学伯克利分校、斯坦福大学和Databricks推出GEPA,优化大型语言模型适应特定任务,比传统强化学习效率高35倍,降低成本,提高准确性,帮助企业快速开发复杂AI系统。

加州大学伯克利分校、斯坦福大学和 Databricks 的研究人员推出了一种名为 GEPA 的新 AI 优化方法,该方法在调整大型语言模型以适应特定任务时显著优于传统的强化学习技术。GEPA 不再依赖数千次试错尝试,而是利用大型语言模型自身的语言理解能力来反思性能、诊断错误并迭代改进指令。与现有技术相比,GEPA 不仅更准确,而且效率更高,最多可减少 35 倍的试验次数。

对于构建复杂 AI 代理和工作流的企业而言,这将直接转化为更快的开发周期、更低的计算成本以及更高效、可靠的应用程序。

现代企业 AI 应用通常不是简单的单次调用大型语言模型,而是复杂的“复合 AI 系统”,这些系统将多个大型语言模型模块、外部工具(如数据库或代码解释器)和自定义逻辑串联起来,以执行复杂的任务,包括多步骤研究和数据分析。

一种常见的优化方法是使用强化学习,例如 Group Relative Policy Optimization (GRPO),这是一种在流行推理模型 DeepSeek-R1 中采用的技术。该方法将系统视为黑箱,运行任务后获得一个简单的成功指标(如 7/10 分),然后利用此反馈逐步调整模型参数。然而,强化学习的主要缺点是样本效率低下,通常需要数万甚至数十万次试验才能有效学习。对于涉及昂贵工具调用(如 API 查询、代码编译)或使用强大专有模型的实际企业应用来说,这一过程非常缓慢且成本高昂。

加州大学伯克利分校博士生 Lakshya A Agrawal 表示,这种复杂性是许多公司的主要障碍。“对于许多团队来说,由于成本和复杂性,强化学习并不实用——他们通常的做法是手动进行提示工程。”他指出,GEPA 旨在帮助那些需要优化基于顶级模型的系统的团队,在不管理自定义 GPU 集群的情况下提高性能。

研究人员将这一挑战描述为:“如何从每次昂贵的试验中提取最大的学习信号,以在数据有限或预算受限的情况下有效适应复杂的模块化 AI 系统?”

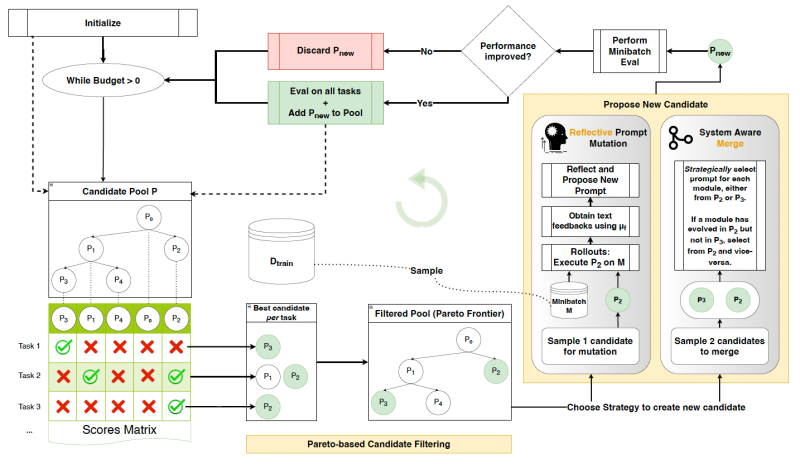

GEPA 框架通过将稀疏奖励替换为丰富的自然语言反馈来应对这一挑战。它利用整个 AI 系统的执行过程(包括推理步骤、工具调用和错误消息)可以序列化为文本,而大型语言模型能够读取和理解这些文本。GEPA 的方法基于三个核心支柱。

首先是“遗传提示进化”,GEPA 将一组提示视为基因库,通过迭代“变异”生成新的、可能更好的版本。这一变异过程由第二个支柱“自然语言反馈反思”驱动。在几次试验后,GEPA 向大型语言模型提供完整的执行轨迹(系统尝试做什么)和结果(正确或错误之处)。大型语言模型随后以自然语言“反思”这些反馈,诊断问题并编写更详细、更精确的提示。例如,在代码生成任务中,它不仅会看到低分,还会分析编译错误,并得出需要指定特定库版本的结论。

第三大支柱是“基于帕累托的选择”,确保智能探索。研究人员设计GEPA系统,不仅关注表现最佳的单一提示,这可能导致陷入局部最优解,而是维护一组多样化的“专家”提示。GEPA跟踪不同实例上表现最佳的提示,形成一份顶尖候选名单。通过从这个多样化的策略集合中抽样,GEPA能够探索更多解决方案,更有可能发现适用于广泛输入的提示。

选择单一最佳候选(左图)可能导致模型陷入局部最小值,而帕累托选择(右图)可以探索更多选项并找到最优解。整个过程的有效性取决于研究者所称的“反馈工程”。Agrawal解释说,关键在于呈现系统已经产生的丰富文本细节,而这些细节通常会被丢弃。“传统流程经常将这些细节简化为单一数值奖励,掩盖了特定结果发生的原因。”他说,“GEPA的核心指导原则是构建反馈,不仅展示结果,还展示中间轨迹和错误的纯文本描述——就像人类用来诊断系统行为的证据一样。”

例如,在文档检索系统中,这意味着列出哪些文档正确检索到,哪些未被检索到,而不仅仅是计算最终得分。

研究人员在四个不同的任务上评估了GEPA,包括多跳问答(HotpotQA)和隐私保护查询(PUPA)。他们使用了开源(Qwen3 8B)和专有(GPT-4.1 mini)模型,将GEPA与基于强化学习的GRPO和最先进的提示优化器MIPROv2进行了比较。

在所有任务中,GEPA显著优于GRPO,最高可提高19%的分数,同时使用的rollouts数量减少了35倍。Agrawal提供了一个具体的效率提升例子:“我们用GEPA优化了一个问答系统,大约用了3小时,而GRPO需要24小时——开发时间减少了8倍,性能提高了20%。”他解释道,“在我们的测试中,基于强化学习的同一场景优化成本约为300美元的GPU时间,而GEPA的成本不到20美元,效果更好——实验中的成本节省了15倍。”

除了原始性能,研究人员发现,GEPA优化的系统在面对新的未知数据时更加可靠。这通过“泛化差距”来衡量,即训练数据和最终测试数据之间的性能差异。Agrawal认为,这是因为GEPA从更丰富的反馈中学习。“GEPA较小的泛化差距可能源于其对每个结果的丰富自然语言反馈——哪些有效,哪些失败,以及原因——而不仅仅是依赖单个标量奖励。”他说,“这可能鼓励系统发展基于更广泛成功理解的指令和策略,而不仅仅是学习训练数据中的特定模式。”对于企业而言,这种改进的可靠性意味着在客户交互中应用更稳健、更适应性强的AI系统。

一个重要的实际好处是,GEPA的基于指令的提示比MIPROv2等优化器生成的提示短9.2倍,后者包含许多少量示例。较短的提示减少了延迟,降低了API模型的成本,使最终应用在生产中运行得更快、更便宜。

论文还展示了利用GEPA作为“推理时间”搜索策略的有希望的结果,将AI从单答案生成器转变为迭代问题解决者。Agrawal描述了一种情景,其中GEPA可以集成到公司的持续集成/持续交付(CI/CD)管道中。当提交新代码时,GEPA可以自动生成和优化多个版本,测试它们的性能,并打开一个包含最佳性能变体的拉取请求供工程师审查。“这将优化变成一个连续的自动化过程——快速生成往往能匹配或超过专家手动调优的解决方案。”Agrawal指出。在CUDA代码生成的实验中,这种方法在20%的任务上达到了专家水平,而GPT-4o的单次尝试则为0%。

论文作者认为,GEPA是迈向新型AI开发范式的基础步骤。但其最直接的影响可能是谁能够构建高性能系统。“我们预计GEPA将促进AI系统建设的积极转变——使这些系统的优化变得对终端用户来说更加容易,他们通常拥有与任务相关的领域知识,但不一定有时间和意愿去学习复杂的强化学习技术。”Agrawal说,“它直接赋予了具有具体任务领域知识的利益相关者权力。”

每日商业洞察,尽在VB Daily

如果你想给老板留下深刻印象,VB Daily为你提供全面支持。我们深入报道企业如何应用生成式AI,涵盖监管变化和实际部署案例,帮助你分享有价值的信息,实现最大投资回报率。

立即订阅

阅读我们的隐私政策

感谢订阅,更多精彩内容请访问VB Daily的其他通讯。

发生错误

(以上内容均由Ai生成)