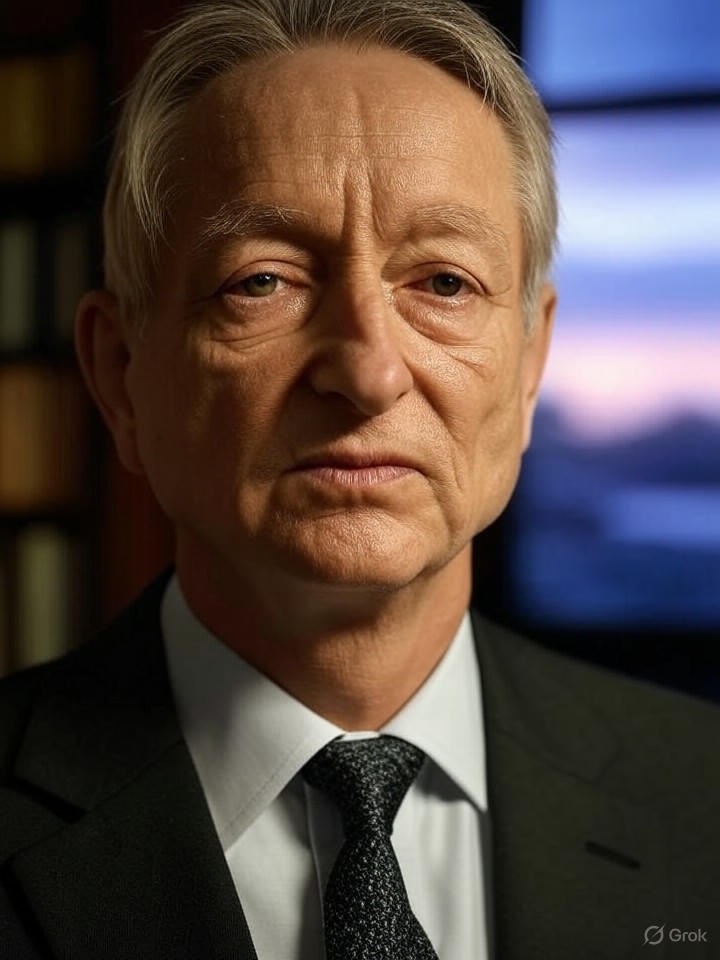

人工智能教父辛顿敦促全球协议避免超级智能人工智能风险

快速阅读: 据《网络新闻》最新报道,杰弗里·辛顿警告,AI若超越人类智慧可能带来灾难,呼吁国际合作建立安全机制,类比冷战核不扩散协议。他批评部分企业淡化风险,强调伦理优先。

据《卫报》报道,2025年7月27日,上海,被誉为“AI之父”的计算机科学家杰弗里·辛顿在全球人工智能大会上发出严厉警告:各国必须合作开发人工智能,否则当这项技术迅速超越人类智慧时,可能会带来灾难性后果。辛顿呼吁各国政府组建一个“机构网络”,引导人工智能系统表现出非敌对行为,类比于冷战时期美苏在核不扩散方面的合作。

辛顿的担忧并非新观点。2023年,他因担心虚假信息和人工智能可能被“恶意使用者”滥用而离开了谷歌。此次最新言论再次强调了国际社会需在训练人工智能以避免危害人类方面加强合作。尽管如此,辛顿也承认由于国家利益,进攻性应用(如网络攻击或操纵性深度伪造)的合作仍不太可能实现。

全球人工智能治理的紧迫性在人工智能即将超越人类认知的时代尤为突出。辛顿认为,任何国家都不希望人工智能凌驾于人类之上,但若没有协同努力,竞争可能导致无法控制的风险。他提出的协作机构不仅是理想主义的,而是基于历史先例的务实蓝图。

在2025年7月28日的一次播客采访中,辛顿称赞了谷歌DeepMind的德米斯·哈萨比斯注重安全的做法,同时批评了OpenAI的山姆·阿尔特曼和Meta的马克·扎克伯格等人对存在性威胁的淡化。这种分歧凸显了利润驱动的创新与预防性监管之间的冲突。社区成员对政府反应缓慢表示不满,认为应通过集体监督让人工智能具备伦理界限。

辛顿的核类比不仅仅是比喻,它唤起了20世纪60年代在超级大国竞争中限制核武器扩散的条约。如今,随着人工智能融入国防和经济,类似的协议可以制定安全标准,或许借助共享数据集或联合研究实验室。尽管进攻性人工智能合作的可能性不大,但防御措施甚至能让对手团结一致。行业专家认为,这一框架必须解决当前挑战,例如人工智能驱动的失业和偏见放大。

实施辛顿的网络面临障碍,包括地缘政治紧张局势和企业游说活动。最近的报道显示,美国科技公司如何影响英国的人工智能政策,谷歌的哈萨比斯据说“审核”了新的法规。这种影响引发了关于公正治理的问题,私人利益可能会压倒公众安全。对于内部人士来说,关键的教训是紧迫性:政府必须优先考虑人工智能伦理而非竞争,建立确保技术服务于人类而不是奴役它的联盟。

随着人工智能的发展,辛顿的警告成为行动的催化剂。受过去成功经验启发的协作模式可以减轻自主武器或社会操控等风险。最终,全球合作不是可选项——它是必不可少的,以利用人工智能的潜力而不招致危险,要求政策制定者和创新者采取大胆的领导。

(以上内容均由Ai生成)